Inteligencia Artificial, factor clave para la ingeniería

Dada la ubicuidad que ya alcanza, debiera ser importante conocer mejor 'de que va esta' aunque solo sea para poder valorar la conveniencia de su aplicación en nuestro producto o trabajo teniendo especial cuidado con su mal uso (como por ejemplo lo que sucede con la publicidad en 'las plataformas de Internet' que, ayudadas por la inteligencia artificial, contaminan todo por captar nuestra atención, no importando capturar comportamientos para interpretar lo que se desea ver y así reconducir, empleando audaces trucos psicológicos, nuestra conducta y capacidad de atención para priorizar los intereses de los anunciantes).

Dado el actual panorama de la IA, y según se vea, como ingenieros, menos aquellos pocos que ya invirtieron años de esfuerzo y trabajo en el lanzamiento relativamente reciente de sus aplicaciones en IA, somos casi todos neófitos en esta materia pues no fue hasta el 2015 que arrancó la IA con destacada vitalidad pues, no en vano, esta bebe de lo que se ha dado en llamar IoT y Big Data. Esto se corrobora por el hecho de que, aun que el vocablo IA se acuñara allá por 1956, los ingresos anuales de su mercado carecieron de relevancia hasta que, pasado el 2014, se produjo el gran salto a cifras superiores a los 100.000 millones de euros de facturación global, estimándose en llegar a más allá de los 2.500.000M.€ para el 2023 (cuando PIB Español en 2017 fue de 1.163.662M.€). De cumplirse estas expectativas (un incremento anual del 48,6% sostenido durante casi una década), queda claro que el tema debe tomarse seriamente.

Para situar rápidamente al lector, se puede decir que, tácitamente, la IA es aquella en la que obtendremos un resultado a partir de los ‘cálculos’ que se le enseña haga una máquina que posee el ámbito y capacidad idóneos para resolver un problema específico, partiendo de una 'base de datos suficientemente grande' con la que se desea obtener un comportamiento patrón o una predicción cognitiva. Por decirlo así, un ingeniero coge un computador y hace un programa como probador de acierto modulando su funcionamiento para conseguir una probabilidad de fallo nula (o muy cercana a ese valor), comparando sus resultados con los valores conocidos de una base de datos de partida. Resuelto el dilema, lo aplica en nuevos supuestos no necesariamente contenidos en la base de datos. De funcionar como se espera, ¡el éxito en su empeño obtiene recompensa!

Que el concepto IA haya cobrado tan renovada fortaleza, ha afectado también a los enfoques por cuanto a desarrollos de nuevo hardware destinado a su uso ya sea de forma parcial o total. Oír de Núcleos Especializados en un solo chip de 4 a 8 núcleos, con tecnología de 7 nm, a 3 Ghz o más, son ya toda una realidad que va llegando para no irse (como las impresionantes prestaciones del micro Kirin 980 de Huawei con sus 6.900 millones de transistores en una oblea de un solo cm2). Y, cabe decir que, según parece, será la parcela ‘móvil’ donde la Ley de Moore seguirá vigente pues en la de ‘escritorio’ hay que recordar que Intel todavía no ha distribuido siquiera procesadores de 10 nm y, sin duda, ya perdió definitivamente el ritmo de la conocida ley.

La colaboración entre Samsung y ARM anuncia los 5 nm para el 2019 y menciona los 3 nanómetros a relativamente corto plazo. Importante destacar para el sector IA que la británica ARM proporcione soluciones que incluyan tecnología orientada al procesamiento específico para la IA que da pie, por decirlo así, a que la Raspberry Pi de 32€/unidad, póngase en su versión 4, incorpore lo anunciado. Tampoco habrá que obviar la pronta llegada del 5G con latencias del orden de pocos milisegundos y velocidades inimaginables que augura tiempos de reacción muy cercanos al ‘Hard Real-Time’.

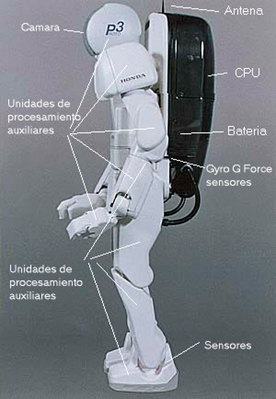

Por cuanto respecta a la taxonomía del mercado de la IA, destacar su amplísima variedad: sistemas de asistencia, sistemas incrustados/ empotrados, sistemas expertos/adaptativos, sistemas robóticos/automatizados y, sin duda y fundamental, lo del autoaprendizaje por medio de las Redes de Neuronas Artificiales por cuanto representa la quintaesencia del casi todo, pues hay que puntualizar que una vez superada esta fase, su resultado se convierte en otro algoritmo y por tanto, el término de inteligencia quedaría relegado a cuanto este se relaciona con el origen de su obtención.

De ese mercado, surgen infinidad de aplicaciones: procesamiento consciente del contexto o del entorno en el que se desarrolla, reconocimiento (de textos, de gestos, del lenguaje natural, de la imagen, de la biometría…), métodos de consulta e interrelación (agentes virtuales), cuidado de la salud y asistencia personal, 'smart robots' y movilidad autónoma, análisis (de videos, del sector financiero y empresarial, de la predicción medioambiental, energética y judicial…), la oscura Ciber-Seguridad y el peligroso Armamento Autónomo, etc. Su potencial es tan elevado que su ubicuidad hará que la 'encontremos por doquier', ¡sin duda!

Introducida someramente su importancia, cabe también otorgar especial relevancia al pasado a través del lenguaje matemático con el que desde hace años que la 'inteligencia' ya está presente en nuestra industria, más desde la era de la digitalización y en particular a través de su programación, que con el advenimiento de los primeros ordenadores (o incluso las primeras calculadoras), se instauró un medio físico para transponer parte de nuestra inteligencia a través de algoritmos haciendo efectivas 'tomas de decisión' por medio de los variados lenguajes de programación que en informática se utilizan.

Como quiera que sea, en cualesquiera sean sus formas, la verdadera parte real y única parecida siquiera a una posible inteligencia de las máquinas es la del autoaprendizaje (consistente en aprender experimentando en forma autónoma y/o vigilada) que será el medio por el cual se obtendrá cualquier subproducto para que la inteligencia, en su nivel más básico, alcance una categoría que se ha dado en denominar como 'IA estrecha'. Con lo que cabe decir que para llegar a la creatividad intelectual con algo de sentido común (la 'IA general' propiamente dicha) se deberá esperar hasta que la IA estrecha madure, y mientras lo hace (que puede que sea más lento de lo esperado por lo que parece), tendremos que conformarnos con ver a esta relegada a la Sci-Fi por el momento.

Por cuanto al grado de inteligencia alcanzado en la actualidad, comentar que los investigadores tratan de darle a la IA la capacidad de construir 'modelos mentales' de nuestro entorno más inmediato (parejo al de un bebé con unos pocos meses de vida, por decirlo así). Pero aun a pesar de sus limitaciones actuales, también es cierto que con el 'aprendizaje profundo' (aun siendo catalogado como 'IA estrecha') se posee un potencial excepcional en el reconocimiento de imagen y de voz, en la traducción automática, en los juegos de mesa… Hoy por hoy, una de las áreas de más intensa investigación es determinar cómo aprender de unos pocos ejemplos de una determinada realidad, en lugar de hacerlo con millones de pruebas que suelen requerir los sistemas de ‘aprendizaje profundo’ actuales. Por mucho que las compañías requieran ‘entrenar a sus neuronas’ en casos reales y tanto tiempo como les sea necesario, por ahora, hacer que estos sistemas supuestamente ‘inteligentes’ sean realmente capaces de hacer su función correctamente, parece que aun requerirá añadir grandes cantidades de lógica donde se reflejen las decisiones tomadas por los ingenieros que los construyen y prueban.

Del como el autoaprendizaje alcanza el acierto en las decisiones

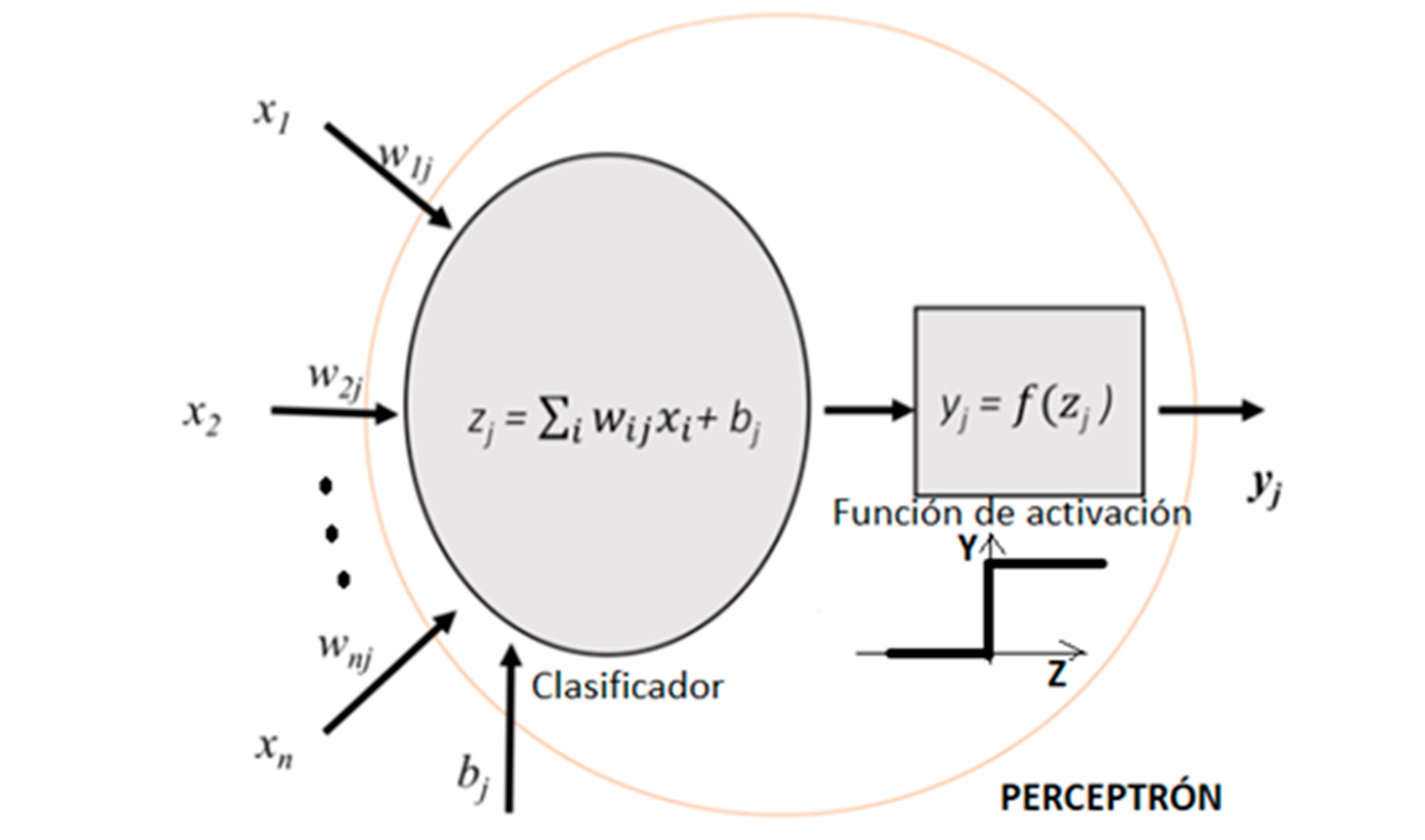

Puntualizar que por su apariencia cotidiana la IA es algo que parece fácil de codificar, pero… es por su especificidad cuando será un triunfo el poderla lograr. Dos niveles por cuanto a la 'IA estrecha', el del aprendizaje automático (Machine learning) pudiéndole llamar de bolsillo (wearable) para entendernos, o mejor todavía, el mucho más intenso (Deep learning) que, digámoslo así, es aquel en el que se somete a la máquina a una labor mucho más 'profunda' e 'intensa' requiriéndose de una gran potencia de cálculo destinada a esta única tarea. Para este último, apuntar entonces, que puede ser un acierto el tener cerca del lugar de desarrollo, de ser ello posible, un Centro de Supercomputación. Dicho todo lo cual, se propone, a partir de ahora, tener un suave primer contacto con eso que se ha dado en llamar Inteligencia Artificial por cuanto a su parte esencial que es la de aprender. Que, como fue dicho, todo lo otro se queda en haber generado mediante el autoaprendizaje, un programa (léase algoritmo) implementable en un hardware existente que pueda tomar decisiones impredecibles predeciblemente (con perdón por el grosero oxímoron), dado que las decisiones predecibles, ya hace mucho tiempo que las venimos resolviendo sin ningún problema, como con un PLC por poner un ejemplo que casi todos conocerán. Cabrá pues, en primera instancia, hablar de 'la Neurona artificial' o del Perceptrón como acuñó en 1957 Frank Rosenblatt al referirse a la LTU (Linear Thershold Unit) por ser esta la unidad básica de ella y cuyo posible esquema responde a

en donde se aprecia que existe una parte denominada Clasificadora que pasa posteriormente por una Función de Activación (filtro que podrá ser de variado tipo) de adecuación a la información que será obtenida a la salida para su manejo posterior por otras neuronas o por la salida final de la red neuronal.

Como se aprecia, su expresión responde a

Clasificador: Z j = bj + Êi W ji * X i

Función de activación (en el ejemplo, el escalón): If Z j >= 0 Then Y j = 1; Else Y j =0

en donde un multiplicador/sumador digital (o incluso analógico, para un Smart-sensor, por su similitud con un simple Amplificador Operacional y un Array de diferentes valores de Resistencias seguido de un Comparador) es lo idóneo.

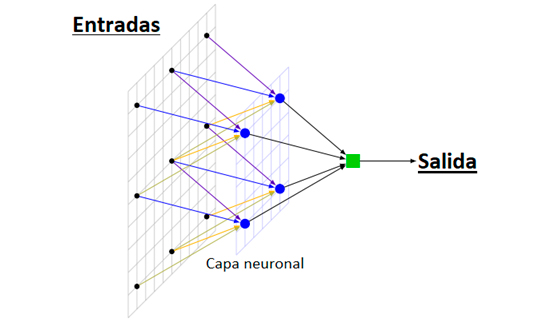

Cabrá en segunda instancia decir, lógicamente, que ésta se fundamenta en algo que pueda ser procesable como vínculo con el hardware disponible, desde una CPU o DSP en donde el cálculo matricial (o el desarrollo en series de Taylor o Fourier) es lo suyo, pasando por la GPU y la FPGA para alcanzar un procesamiento en paralelo, para llegar a la TPU que en 'Computación Clásica es la hecha a uso y medida para la IA' y, yendo más allá todavía se nos anuncia 'entusiásticamente' la Computación Cuántica… El propósito final no es otro que el de establecer una red neuronal como se muestra simbólicamente en el siguiente gráfico,

en el que se aprecia el procesamiento en paralelo y en donde, obviamente, cuantas más capas se añadan una detrás de la otra, más “Deep” será la IA (como lo es la red neuronal convolucional). Señalar la tridimensionalidad de la representación.

Como tercera y última instancia (la del software propiamente dicho y por ende la de la verdadera IA) se obtiene lo denominado como aprendizaje que, simplificando certeramente, consiste en lo de ir calculando reiterativamente, en sucesión de pruebas de acierto/fallo, el valor de salida (o label) que resulte más apropiado para hallar los factores multiplicativos Wij y la bj (o bias) de cada Clasificador, para ajustar a este al mínimo error final (o loss). O más claramente: se aplica lo que se denomina algoritmos de regresión que modelan la relación entre distintas variables de entrada (o features) utilizando una medida de error (o loss) la cual se minimizará en un proceso iterativo para poder realizar predicciones 'lo más acertadas posibles' experimentalmente. Añadir que la información del 'Big Data' es de primordial importancia como base de datos para su entrenamiento, validación y posterior aplicación y despliegue.

Dicho todo lo cual (suficiente para hacernos cargo de a lo que nos enfrentamos y volviendo al principio del escrito), la diferenciación es clara entre acometidos específicos del ARM con el que Samsung trabaja y la de un Supercomputador. En esta introducción se procura diferenciar a la tercera instancia de sus dos precedentes. Por consiguiente, introducir que existe una IA en bruto ('raw AI' por así decirlo) para las dos primeras instancias, en donde se puede excluir una grandísima parte de la tercera para poder emplear un Hardware de muchos menos recursos, una vez, otra máquina más sofisticada y muchísimo más potente, le aporte y seleccione (eliminando neuronas llegado el caso) los 'Clasificadores' con valores ya conocidos y concretos de los parámetros Wij y bj.

Esta 'supermáquina' podría basarse en la Supercomputación clásica a la que se puede tener acceso como servicio de alquiler (o hasta subvencionado y de ahí la importancia de poseer cerca un ’Barcelona Supercomputing Center’ por ejemplo). Pero esta poco o nada tiene que ver con la que llevamos en el bolsillo que, obviamente, de ella se obtendrían los valores apropiadamente ajustados a un determinado criterio preestablecido, y así las 'neuronas en bruto' serían ya lo suficientemente maduras ('fundiendo' fusibles en una FPGA o cargándole una determina App para ilustrarlo aún más sencillamente) como para NO requerir del autoaprendizaje en su totalidad (pero no excluyéndolo del todo pues los 'patrones' de comparación, como son por ejemplo huellas y fisonomías por ejemplo, es de prever que sufran cambios a lo largo del tiempo según la morfología del individuo).

La Computación Cuántica se postula como paradigma para la IA, además de la solución a problemas inabarcables como ella misma parece ser (convirtiéndola en la némesis de su propia incertidumbre)

Al respecto de la Supercomputación Cuántica y dado de su 'extraño' proceso cuántico aleatorio, decir primero que, con eso de que el qubit (quantum bit) posea a la vez el estado de 0 y 1 (superposición: una partícula mientras no haya observación puede existir en muchos estados o, mejor dicho, posiciones) y, segundo que, con eso de que se pueda forzar (usando 'un truco' llamado interferencia) una posibilidad determinada más que la otra según nos interese obtener una u otra salida como resultado final (a partir del fenómeno cuántico de entrelazamiento entre 2 partículas de forma que un cambio en el estado de una, afecta al de la otra instantáneamente), se constatará fácilmente el símil con lo que el Perceptrón viene haciendo y de ahí se deduce su más que idoneidad futura. De la máquina fabricada por IBM de 50 qubits 'solamente' (la más potente y operativa en la actualidad), se obtienen 250 posibles estados simultáneos, es decir almacenaría, de por sí, lo equivalente a bastante más de mil billones de combinaciones de posibles estados simultáneamente, un 'Peta-LoQueSea' en términos clásicos. Aunque en este tema, todo es tan 'raro' que, es más que evidente que se quiere construir con una gran dosis de entusiasmo, sistemas de IA más avanzados con ayuda de una tecnología que es tan revolucionaria que apenas existe y, en honor a la verdad, habrá que ver y esperar pues la computación cuántica, si bien ya no es el otrora deseo de físicos como el de Richard Feynman, se antoja la 'sangre, sudor y lágrimas' de no pocos ingenieros empeñados en ella.

Introducidos suave y escuetamente los vericuetos de la IA contemporánea en su vertiente más interesante, única y fundamental, la del aprendizaje, dejarlo aquí advirtiendo que esto no ha hecho más que comenzar.