¿Cómo de buena es una inteligencia artificial?

Maximilian Sand, Teamleader Artificial Intelligence, Dallmeier electronic GmbH & Co.KG

02/11/2021También los sistemas tienen dificultades de aprendizaje

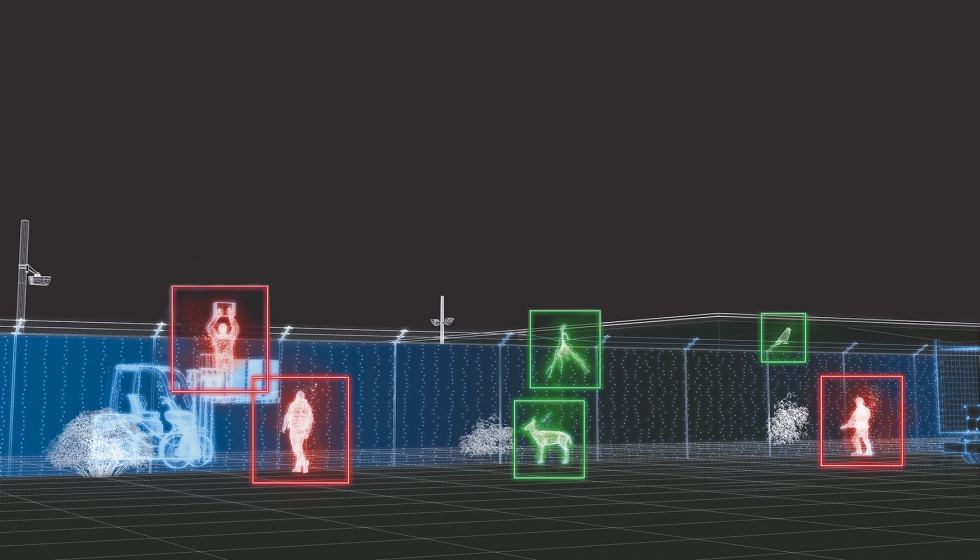

Ya desde hace tiempo, la tecnología de videoseguridad incorpora procedimientos basados en inteligencia artificial (IA). Cada vez más aplicaciones y productos nuevos utilizan algoritmos para ofrecer análisis nuevos o hacer considerablemente más robustos los análisis ya existentes. El objetivo es un claro valor añadido para los usuarios, y los resultados hablan por sí solos: si en el pasado, por ejemplo, con el procesamiento clásico de imagen, suponía un gran esfuerzo reconocer de forma fiable un árbol movido por el viento como falsa alarma, hoy en día una IA lo realiza sin problemas.

La característica distintiva esencial entre los análisis de imagen o vídeo con procesamiento clásico de imagen y aquellos con inteligencia artificial es que los algoritmos ya no son ‘solamente’ programados sino ‘enseñados’ con una gran cantidad de datos. Mediante estos datos, el sistema aprende a reconocer patrones y así, por ejemplo, diferenciar un árbol de un intruso. Pero el concepto del aprendizaje mecánico plantea también problemas y desafíos nuevos. Un ejemplo destacado para ello son las diferencias en la calidad de reconocimiento de distintos grupos étnicos, una problemática que incluso ha llegado a los titulares. Aunque el fondo es relativamente simple: sólo cuando existen datos en suficiente cantidad y con suficiente diversidad e igual distribución, una IA puede aprender de manera robusta.

Inteligencia artificial ‘buena’ y ‘mala’ – o: la calidad del sistema IA

Todo ello lleva a preguntarse por la capacidad de rendimiento de un sistema que usa inteligencia artificial. ¿Qué medidas sirven para poder comparar, por ejemplo, dos procedimientos, diferentes sistemas o fabricantes? ¿Qué significa si en un folleto se promete p.ej. una ‘precisión de detección del 95%’ o un ‘reconocimiento fiable’? ¿Cómo de buena es una precisión del 95%? Y, en definitiva, ¿qué es un ‘reconocimiento fiable’?

Para ello, antes que nada, hay que entender cómo pueden evaluarse los procedimientos IA. El primer paso es la definición específica por parte de la aplicación y del cliente de qué significa ‘falso’ y qué ‘correcto’, especialmente en casos límites: por ejemplo, en un sistema de reconocimiento de personas, ¿hay que valorar una detección como correcta si en la imagen o vídeo no se ve una persona real sino sólo un cartel publicitario con una persona? Este y otros parámetros han de ser establecidos. Una vez exista esta definición, se necesita un conjunto de datos en que se conozcan los resultados correctos esperables. La IA analizará ahora este conjunto de datos y determinará así la proporción de detecciones correctas y falsas. Las matemáticas proporcionan aquí al usuario diferentes métricas, tales como la sensibilidad (proporción de las detecciones esperadas que realmente han sido detectadas) o la precisión de acierto (proporción de las detecciones que realmente son correctas). De modo que, la “calidad” de la IA, al fin y al cabo, siempre es una declaración estadística sobre el conjunto de datos de evaluación que se ha usado.

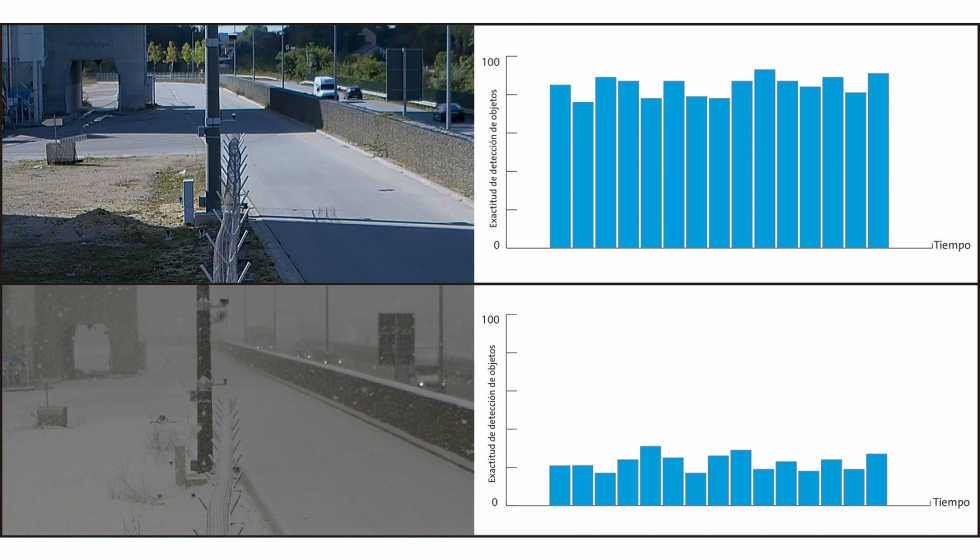

¿Verano o invierno?

Cómo de útil es realmente esta declaración para el usuario o cliente potencial de un sistema depende de la distribución del conjunto de datos. Una evaluación puede certificar un buen rendimiento de detección. Pero si el conjunto de datos se basa exclusivamente en imágenes de meses de verano, esta evaluación no tiene ningún valor informativo sobre la calidad de la IA en invierno ya que las condiciones lumínicas y meteorológicas pueden diferir considerablemente. En consecuencia, en general: las declaraciones sobre la calidad de un análisis IA –particularmente, aquellos con números concretos como “99.9%”–, hay que tomarlas con cautela cuando no se conocen todos los parámetros. Sin conocimiento del conjunto de datos utilizado, de la métrica aplicada y de otros parámetros, no es posible una afirmación inequívoca sobre el grado de representatividad del resultado.

No puede haber indicaciones exactas

Cada sistema tiene sus límites, incluso, naturalmente, los sistemas IA. Por tanto, conocer los límites es el requisito básico para tomar decisiones fundadas. Pero también aquí, se cruzan estadística y realidad, como se puede ver en el siguiente ejemplo: una IA reconoce peor, lógicamente, objetos en la imagen/vídeo cuanto más pequeños son. La primera pregunta, que se plantea a un usuario antes de la compra de un sistema, es la distancia máxima hasta la que los objetos pueden ser detectados, ya que influye en el número de cámaras necesarias y, por tanto, en los costes del sistema entero. Pero indicar una distancia exacta no es posible. Simplemente, no existe ningún valor hasta el cual el análisis proporcione resultados 100% correctos y otro valor desde el cual una detección no es posible. Una evaluación aquí sólo es capaz de facilitar estadísticas como, por ejemplo, la precisión de la detección en función del tamaño del objeto.

Mejor comparar directamente

En relación a los límites del sistema se ha optado por describir, en la medida de lo posible, los límites del sistema con valores mínimos o máximos concretos: por ejemplo, en las hojas de datos de productos. Entre aquellos estarían la distancia mínima o una resolución mínima. Esto es razonable, ya que los clientes o instaladores necesitan puntos de referencia para poder evaluar el sistema. Sin embargo, evidentemente, queda aún mucha incertidumbre, p.ej. si estos valores límites los indica el fabricante de forma más bien conservadora u optimista. El usuario hará bien en tener siempre presente que en el análisis de vídeo pueden no existir límites claros y definidos. Con cada sistema será así: también dentro de determinados parámetros se producirán errores y, al mismo tiempo, bajo condiciones buenas, se podrán originar resultados útiles, incluso sobrepasado el límite.

Si un usuario desea determinar la verdadera calidad de un análisis basado en IA, esto sólo será posible a través de una comparación directa; los números y parámetros de los distintos fabricantes son demasiado diferentes. Y, además, las condiciones marco y el input, por supuesto, tienen que ser los mismos en todos los sistemas. Una prueba real con productos de demo, prestados o similares, es una buena posibilidad para ello. Adicionalmente, el rendimiento del sistema se muestra justo en el caso de uso requerido. Es, por cierto, también la clave a la hora de evaluar el rendimiento de sistemas IA en general: depende totalmente del uso en cada caso. Éste debería estar especificado de manera lo más exacta posible. Entonces, con la solución correcta, será posible dar un verdadero valor añadido al cliente.