¿Sabes qué son las cuatro uves del big data?

Según el informe de 2015 de Aberdeen Group ‘Data-Driven Manufacturing in the Age of Insight’, el 45% de las organizaciones afirmó que obtener acceso a datos de diferentes áreas del negocio era acuciante para satisfacer sus necesidades de análisis. Con datos mejores y más completos, los fabricantes pueden conocer mejor su negocio para optimizar las operaciones y abordar los problemas mecánicos o de seguridad por adelantado antes de que surjan los problemas.

Aunque disponer de datos más fiables más rápidamente es un gran paso en la dirección correcta, también crea nuevos desafíos, que IBM ha acuñado como ‘Las cuatro uves del big data’.

Las cuatro uves son:

- volumen (escala de los datos),

- velocidad (análisis de la transmisión de datos),

- variedad (diferentes formas de datos) y

- veracidad (incertidumbre de los datos).

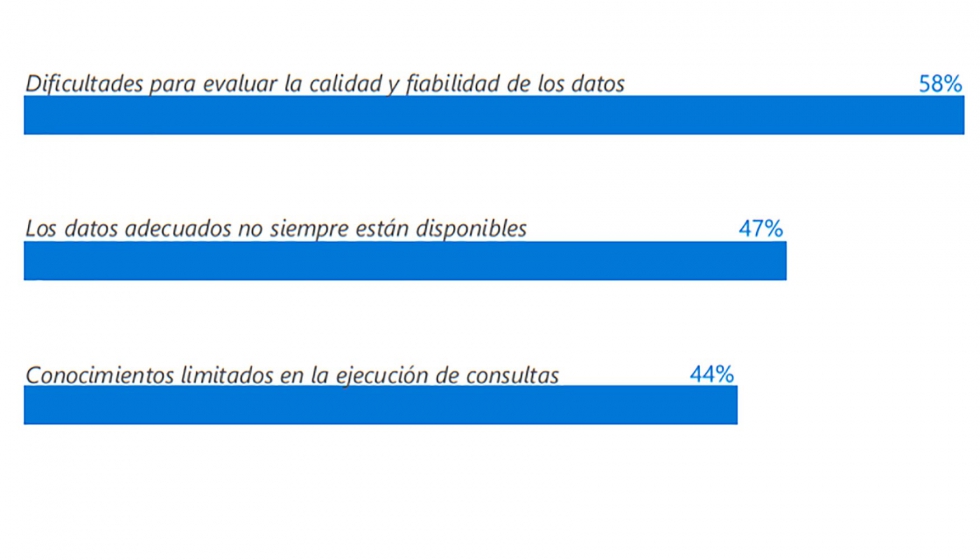

Con el crecimiento del big data, no hay duda de que las organizaciones están empezando a sentir estos desafíos. Según el informe de 2015 de KPMG ‘Going Beyond the Data’, el 58% de las empresas globales citó la calidad y fiabilidad como un gran desafío a la hora de tomar decisiones basadas en datos y análisis, mientras que el 47 % cree que no dispone de acceso suficiente a los datos que necesita. En definitiva, los big data son demasiado grandes. Hasta la fecha, la capacidad de una empresa de aprovechar sus datos ha estado limitada debido a la carencia de conocimientos internos, a herramientas limitadas y a costes prohibitivos, pero las capacidades de las empresas están poniéndose al día. Los fabricantes ahora confían en un nuevo tipo de herramientas de análisis diseñadas para hacer que los big data sean más fácilmente accesibles, incluido el machine learning, los análisis predictivos y las herramientas de automatización. Los big data, por sí solos, no sirven para nada; se vuelven útiles cuando pueden proporcionar conocimiento, hacer los procesos más eficientes y permitir que los fabricantes operen con mayor eficacia. Estas herramientas ayudan a los fabricantes con la detección, clasificación, cálculo de probabilidades y optimización.

La detección consiste en la identificación de patrones (tendencias), objetivos y valores atípicos. Las herramientas de visualización de datos que convierten grandes conjuntos de números en tablas y gráficos permiten que las tendencias sean más fáciles de identificar y que los valores atípicos salten a la vista con sencillas comparaciones visuales. La incorporación de datos en tiempo real añade velocidad a la simplicidad que la visualización de datos proporciona.

Los fabricantes pueden usar estas herramientas para realizar un seguimiento de los cambios de control de calidad y de problemas de mantenimiento, detectar tendencias del mercado emergentes o identificar posibles problemas en la cadena de suministros antes de que se materialicen. La clasificación permite a las empresas aislar, distribuir, filtrar, ordenar y comparar los datos. También ayuda a los fabricantes a ser más ágiles al permitirles aislar y clasificar inventario, piezas o necesidades de producción. Las herramientas que proporcionan la capacidad de automatizar el proceso de clasificación pueden optimizar la producción y permitir a los fabricantes adaptarse mejor a las cambiantes demandas. Además, permiten a los fabricantes crear productos más personalizados y realizar ventas cruzadas más inteligentes.

Conocer la probabilidad de que acontezcan eventos futuros es esencial para tomar decisiones estratégicas. El cálculo de probabilidades se puede usar para demostrar la posibilidad de un acontecimiento, para comparar varios eventos o para mostrar la distribución de los posibles resultados.

Las herramientas de análisis predictivo ayudan a los fabricantes a dominar la administración de inventarios, determinar los precios óptimos de los nuevos productos, llevar a cabo tareas de mantenimiento predictivo y preventivo, predecir las necesidades de ventas y soporte o administrar mejor el flujo de efectivo. A medida que la agilidad gana importancia entre los fabricantes, la optimización se convierte en una parte importante de los análisis, que les ayuda a ser más hábiles. Esto se puede conseguir optimizando los tres pilares anteriores: mayor rapidez y precisión de detección, clasificación y cálculo de probabilidades. A medida que hay más datos reales disponibles, las nuevas herramientas de machine learning ayudan a los fabricantes a mejorar su rendimiento comparando los resultados previstos con los resultados reales y optimizando sus algoritmos en consecuencia.

Y, ¿en la industria cárnica?

La industria cárnica y avícola es un ejemplo de la trascendencia de la recogida y manejo de los datos en una organización. Según palabras de José Luis Pascual, director de TI del Grupo UVESA, “la recogida de datos en los procesos de producción es el primero y principal eslabón para el buen funcionamiento de toda la empresa. Los datos recopilados en tiempo real en la planta son cruciales para la toma de decisiones en el resto de departamentos y para aumentar la competitividad al ritmo que la demanda actual exige”.

De esta forma es como funciona AX.meat de Neodata, la solución de gestión especializada en los procesos de las industrias cárnicas, basada en la recogida de datos en tiempo real y que permite a las empresas dar el salto a convertirse em organizaciones inteligentes.