Gestión de datos de medición con soluciones Open Source

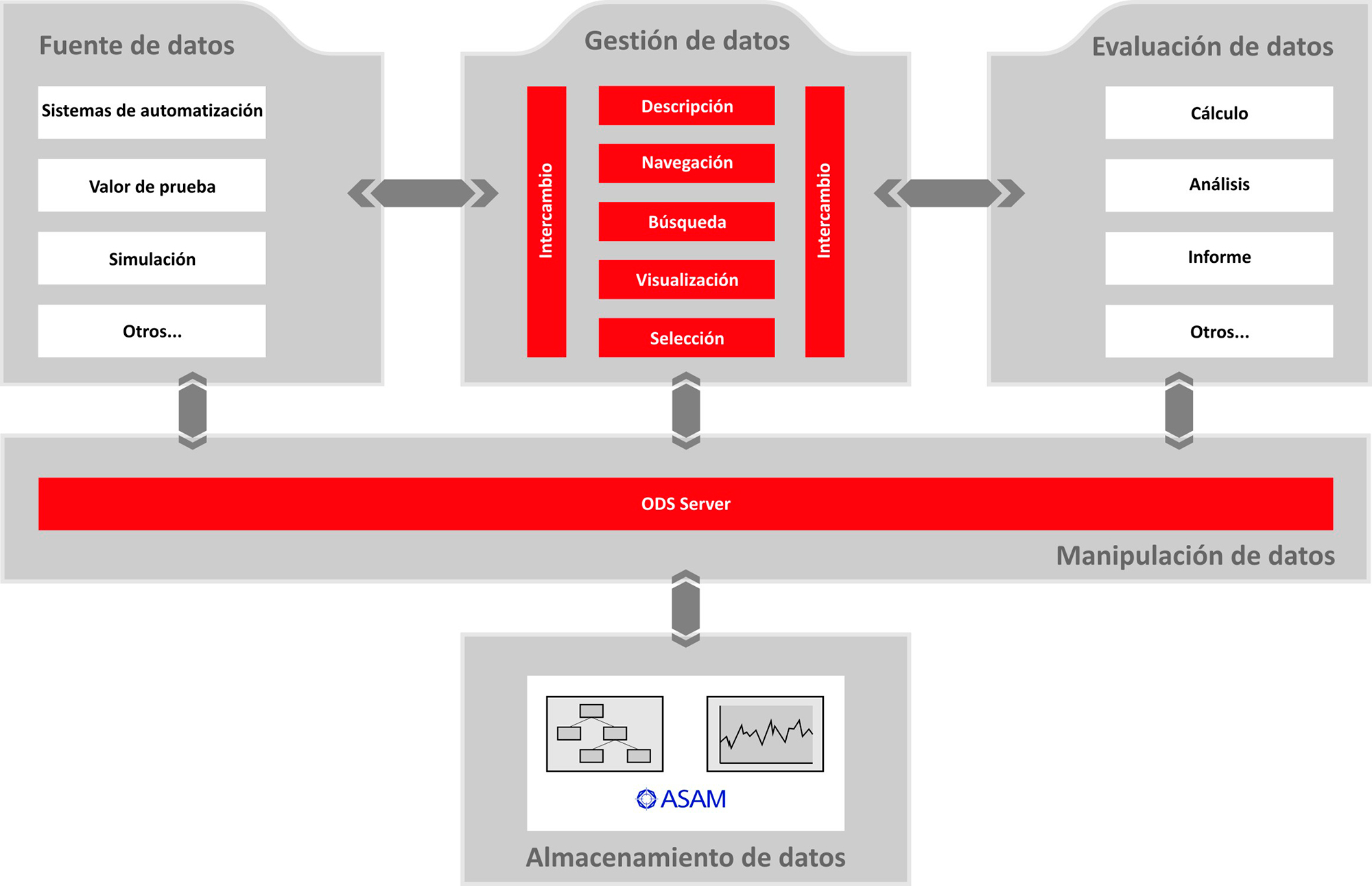

Para que sea posible interpretar y comparar correctamente y en todo momento los datos de medición, debe elaborarse información descriptiva sobre ellos.

Los departamentos especializados en controlar la electrónica, la mecánica, los grupos constructivos o incluso, vehículos completos, generalmente documentan los resultados a nivel local. Debido a las soluciones aisladas que se obtienen, los datos de medición rara vez se utilizan fuera de su proceso de elaboración. Sin embargo, estos datos son valiosos, ya que representan el conocimiento sobre los productos y su desarrollo. Un sistema de gestión de datos de medición combinado con tecnologías Big Data permite utilizar estos datos a largo plazo de forma sistemática y extrapolarlos a todo el ciclo de vida del producto.

Dado que hay componentes individuales de los vehículos que a menudo se incorporan sin modificaciones en los modelos sucesores, también pueden ser relevantes los resultados de pruebas anteriores. Un almacenamiento de datos en el que pueda buscarse bien, así como procedimientos con los cuales puedan reconocerse patrones y relaciones independientemente de los diferentes ensayos, proyectos, secciones y lugares, ofrecen ventajas competitivas decisivas. Además, para poder citar los controles realizados en caso de un proceso de responsabilidad por productos, en la industria automotriz los datos a menudo se deben almacenar por un periodo de hasta 30 años. Por lo tanto, debería acordarse el objetivo de que los datos de medición y la documentación de los ensayos estén disponibles durante todo el ciclo de vida de un producto.

Los almacenamientos tradicionales llegan a sus límites

Sin embargo, los datos de medición se acumulan en enormes cantidades y rebasan cada vez más los límites de lo que se puede almacenar en los servidores de archivos tradicionales de manera que resulte económicamente viable. En algunas áreas, como por ejemplo en los sistemas de asistencia para el conductor, se alcanzan varios terabytes por semana. Todo aquel que se remita al valor fundamental de los datos de medición y quiera almacenarlo todo, se ve una y otra vez frenado por restricciones económicas. Teniendo en cuenta los petabytes de datos, decir "puede que todavía los necesitemos" suena como el argumento de un acaparador compulsivo de datos de medición que debe ser obligado a seleccionar los datos más importantes. Sin embargo, los gigantescos volúmenes de datos no son un problema específico de los operadores de bancos de pruebas. Bajo el término Big Data hoy en día ya se están utilizando con éxito en otras áreas diversos métodos para que el almacenamiento y la evaluación de grandes volúmenes de datos resulten provechosos. Las masas de datos de medición también pueden controlarse de este modo.

Uno de los retos en la introducción de un sistema de gestión de datos de medición para toda la empresa son los formatos propietarios de los datos procedentes de los equipos de medición y bancos de pruebas. Para que sea posible interpretar y comparar correctamente y en todo momento los datos de medición, debe elaborarse información descriptiva sobre ellos. Estos llamados metadatos sirven para poder evaluar el contexto profesional, organizativo y técnico de las mediciones. Este contexto incluye, por ejemplo, la descripción exacta del objeto de ensayo, de los instrumentos de medición utilizados y del proceso de ensayo, así como los datos relativos a la organización y a la orden del ensayo. Esta información es fundamental para poder navegar y buscar más tarde de forma precisa en las bases de datos.

Un estándar que desde hace más de una década ha demostrado ser el mejor como base para este tipo de almacenamiento de datos de ensayos es ODS (Open Data Service) de ASAM e.V. (Association for Standardisation of Automation and Measuring Systems). El estándar es mundialmente utilizado por un gran número de renombradas empresas.

Soluciones Open Source con garantía de futuro

Con ayuda de las plataformas de software adecuadas, las soluciones basadas en ODS pueden ser implementadas hoy de forma económica y con garantía de futuro. El módulo de software Open Source openMDM es un ejemplo de una de estas plataformas. Los orígenes de openMDM se hallan en un sistema de gestión de datos de medición de Audi que ha sido desarrollado desde 2008 por una comunidad abierta de aproximadamente 30 fabricantes de automóviles, proveedores y prestadores de servicios, hasta constituir una solución empresarial extremadamente versátil y escalable. Con la fundación de openMDM Eclipse Working Group en el año 2014 se ha establecido también el marco organizativo en el cual puede impulsarse aún más intensivamente el desarrollo continuo y la difusión internacional de openMDM. Las principales fuerzas motrices son aquí, entre otras, Audi, BMW y Daimler.

openMDM: Un entorno de trabajo abierto e independiente para la gestión de datos de pruebas y de medición.

Los componentes de software de openMDM asisten a los usuarios en la realización de los pasos de trabajo individuales del proceso de ensayo y permiten una estandarización o automatización de las secuencias de trabajo que se repiten. El apoyo del proceso comienza con la descripción de los ensayos y abarca desde la orden para realizar el ensayo y el almacenamiento de los datos obtenidos hasta la navegación, la búsqueda y la selección de los datos del ensayo. Los sistemas de medición y las herramientas de análisis de diferentes fabricantes se pueden integrar en el proceso de forma flexible a través de interfaces abiertas. De este modo, y sin grandes gastos de desarrollo, es posible importar los datos de medición desde los diferentes sistemas de medida y almacenarlos y administrarlos junto con su información descriptiva (metadatos) conforme a ASAM ODS. A través de la navegación o la búsqueda, los datos en openMDM se pueden buscar, agrupar y transferir a diferentes herramientas de análisis para su procesamiento posterior.

De esta manera, las empresas están en condiciones de estandarizar sus procesos de ensayos en las diferentes áreas técnicas y de organizarlos sin depender de los fabricantes. Con ello se logra la transición de soluciones propietarias y locales a entornos de trabajo realmente integrados y con las mejores herramientas disponibles. Esto significa que, gracias al enfoque abierto e independiente del fabricante de openMDM, es posible utilizar aquellas herramientas (por ejemplo, sistemas de medición, herramientas de análisis, programas de evaluación, etc.) de diferentes fabricantes que hayan demostrado ser las más apropiadas para la realización de ciertas tareas o secuencias de trabajo en el proceso de ensayo de un determinado departamento técnico. A pesar de que los sistemas sean diferentes, el resultado es una visión general y coherente de todos los datos de ensayo de un departamento.

Por fin suficiente espacio para los resultados de medición

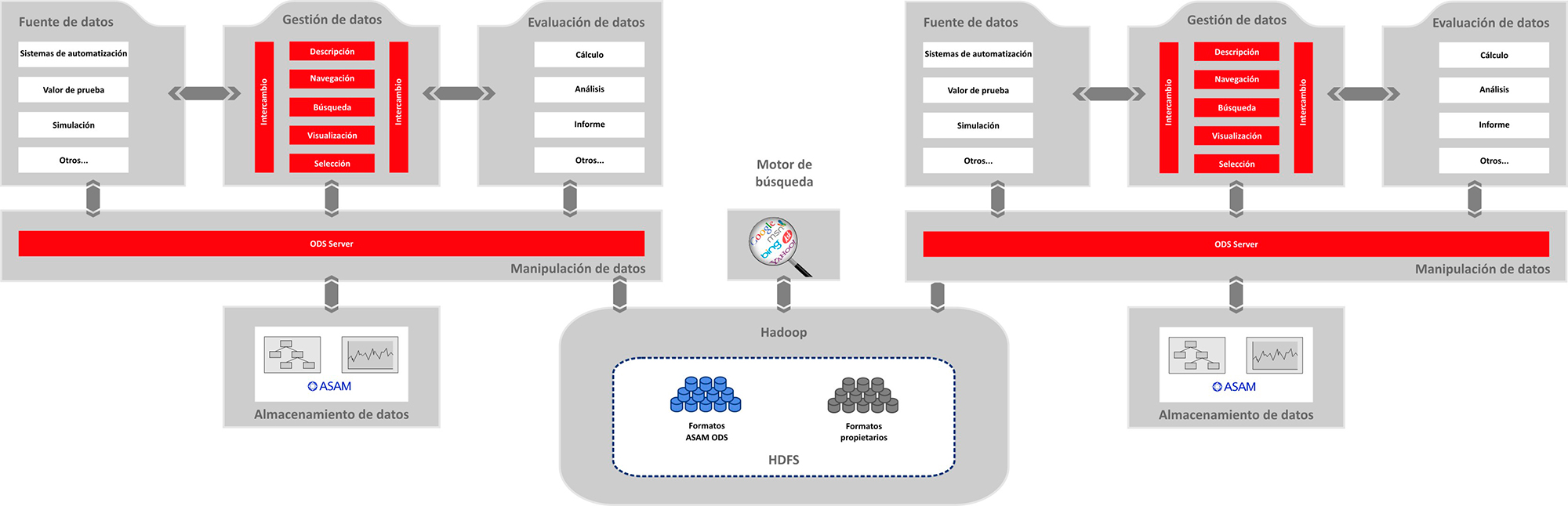

Sin embargo, el volumen de los datos de ensayo de los departamentos crece constantemente y también aumenta la diversidad de los datos en lo que se refiere al tipo (por ejemplo, estructurados, no estructurados, parcialmente estructurados) y al formato (propietario, estandarizado, vídeo, audio, gráfico, XML, texto, Office, etc.). A fin de poder almacenar estos datos de forma económica para posibles evaluaciones posteriores, Peak Solution propone almacenarlos en hardware básico. También en este caso se apuesta por una solución de libre acceso: el proyecto de código abierto Hadoop de Apache Software Foundation permite el almacenamiento y el procesamiento distribuidos de grandes volúmenes de datos en entornos distribuidos en forma horizontal. Un componente central de Hadoop es HDFS (Hadoop Distributed File System). Se trata de un sistema de archivos distribuido con el cual pueden distribuirse grandes volúmenes de datos de forma segura y sin errores en varios miles de servidores dentro de un clúster ('scale out').

Lo más destacado es que para ello no se necesitan servidores especiales y costosos, sino que se puede usar hardware básico. Por lo tanto, Hadoop Distributed File System es 20 veces más económico por terabyte que las redes de área de almacenamiento o las bases de datos analíticos (como, por ejemplo, Enterprise Data Warehouse). No hay que pagar tasas de licencias y no es necesario comprometerse con un determinado fabricante de hardware. HDFS se encarga de forma completamente automática de la gestión de los datos (es decir, la división, distribución y réplica en los nodos del clúster). Para los usuarios, el acceso a HDFS se estructura como el de un sistema virtual de archivos.

Hadoop: Una base de datos a nivel empresarial para la información del entorno de ensayos.

Interfaces y métodos unificados

La combinación de openMDM y un clúster Hadoop funciona del siguiente modo: al realizar la importación en un sistema openMDM específico de la aplicación, los datos de medición se convierten desde los diferentes sistemas de medidas al formato de archivo normalizado ODS y se asocian con la información descriptiva (metadatos). Una instancia intermedia como, por ejemplo, el servidor Peak ODS de Peak Solution almacena tanto los archivos ODS como también los formatos originales propietarios en HDFS. El servidor se ocupa de que los datos que se crean o que son necesarios para los bancos de pruebas, las instalaciones de medición, los sistemas de simulación, las herramientas de análisis y los programas de evaluación de los diferentes fabricantes, sean almacenados o cargados conforme a ODS. Los datos pueden ser: metadatos (por ejemplo, órdenes de ensayos y simulación, descripciones de ensayos o información de calibraciones), datos de medición (por ejemplo, valores de medidas individuales, datos de imagen, vídeo y audio o datos reales de la realización del ensayo), así como datos de resultados (por ejemplo, resultados de evaluación y de cálculo).

Independientemente del origen y formato de los datos, el servidor Peak ODS se ocupa de que las diferentes aplicaciones puedan acceder a ellos a través de interfaces y métodos unificados. Gracias al encapsulamiento de las interfaces, ya no importa el tipo de almacenamiento de datos en detalle para la respectiva aplicación cliente. Esto significa que todos los sistemas de adquisición de datos, de automatización, de simulación o de análisis compatibles con ODS pueden almacenar y cargar datos de configuración y de resultados conforme a ODS con ayuda del servidor Peak ODS.

Con este procedimiento también pueden guardarse los datos que antes había que sacrificar por falta de espacio. Los metadatos se guardan en la base de datos relacional de la aplicación openMDM y, con la ayuda del software libre Apache Lucene se va elaborando continuamente un índice. Este índice y la tecnología del motor de búsqueda Lucene, que se utiliza por ejemplo en Wikipedia, permiten ahora lo que se quería en un principio: una gestión de datos de medición para toda la empresa. Mediante la minería de textos y una navegación explorativa e iterativa, el motor de búsqueda ofrece la posibilidad de encontrar en toda la base de datos, más allá de las aplicaciones y secciones, ensayos con características especiales. Siempre que el usuario tenga los correspondientes derechos de acceso, puede consultar los datos de ensayos hallados –incluso los de otros departamentos de pruebas– para realizar comparaciones y análisis propios.

Múltiples posibilidades de análisis

Además de un lugar de almacenamiento rentable para datos masivos, el clúster HDFS ofrece múltiples posibilidades de evaluación, generalmente englobadas bajo el término Big Data Analytics. Los datos de las diferentes aplicaciones y departamentos se pueden relacionar entre sí y derivar en nuevas relaciones. Así, por ejemplo, si se desarrollan simulaciones para pruebas SiL y HiL de componentes de un sistema de asistencia para el conductor, se puede obtener en determinadas circunstancias información valiosa a partir del análisis de los datos de la prueba de conducción. Con métodos basados en grafos pueden modelarse redes semánticas para reconocer más que las meras relaciones evidentes y las dependencias entre diferentes objetos de datos a partir del entorno de ensayo. Sobre la base de esta información, se pueden establecer modernos sistemas de indicaciones y recomendaciones, así como bases de datos de conocimiento para ingenieros de ensayos. A partir del conocimiento especializado de los departamentos individuales se desarrolla un conocimiento sobre todos los ensayos que va más allá de la empresa.

El enfoque de Big Data permite investigar las conexiones globales. Por ejemplo, en el caso de las pruebas de conducción que se realizan en todo el mundo bajo las más diversas condiciones, es posible registrar la comunicación en el bus de datos de los diferentes vehículos probados. De forma paralela, a través de sensores se puede recopilar numerosa información sobre los componentes individuales del vehículo (por ejemplo, motor, transmisión, frenos, etc.) y, mediante el uso de sistemas de medición por vídeo, recabar información sobre la carretera y el entorno. Esta información permite realizar análisis completos del comportamiento de determinados tipos de vehículos en situaciones definidas y, si es necesario, también sirve como indicación del potencial para optimizar la interacción de los componentes individuales del vehículo. En un sentido más amplio, los datos de medición son también conocimiento para el continuo desarrollo del producto.

La idea de Big Data apenas acaba de llegar al área de gestión de datos de medición. Aún no puede preverse cuáles son las preguntas que se puede hacer a los datos masivos ni tampoco cuáles son las posibilidades de análisis que ofrecen. Sin embargo, gracias a la interacción de openMDM con Hadoop y Lucene, es posible realizar la gestión de datos de medición de toda la empresa utilizando grandes bases de datos, más concretamente basándose en instalaciones específicas openMDM en los diferentes departamentos técnicos, desde la construcción de motores y chasis, hasta la asistencia al conductor y el entretenimiento de a bordo. Este es un aspecto importante, ya que la colaboración de socios de desarrollo externos y los desarrollos de plataformas para toda la empresa van en aumento. Gracias a la "generosa" recopilación de datos en el clúster HDFS, los datos marginales en el contexto de desarrollo que hasta el momento eran eliminados, son ahora analizables incluso cuando proceden de prestadores de servicio. De este modo, los fabricantes de equipos originales que se suman al camino de Big Data, tienen un conocimiento más amplio del ciclo de vida de sus productos y subsistemas, y no solo un único informe de prueba final.