Digital y seguro, nuevas ideas en la digitalización de plantas

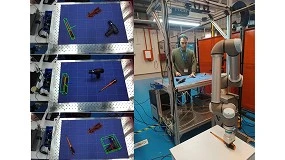

Como se muestra en la figura 1, el ‘edge computing’ se centra en procesar los datos cerca de su origen, en el ‘borde’ de la red, sin la necesidad de enviar los datos a un servidor central. Esto reduce la latencia y permite respuestas rápidas, lo que es esencial para aplicaciones en tiempo real como el IoT y sistemas industriales. Sin embargo, puede tener limitaciones en cuanto a capacidad de procesamiento y almacenamiento en comparación con el cloud computing, que proporciona acceso a recursos escalables y almacenamiento a través de Internet desde centros de datos remotos.

Por otro lado, el ‘fog computing’ emerge como un modelo intermedio entre el ‘edge’ y el ‘cloud computing’, ubicándose generalmente a medio camino entre el lugar donde se generan los datos y los centros de datos en la nube [1]. Este paradigma amplía las capacidades del ‘edge computing’ al distribuir el procesamiento, almacenamiento y aplicaciones más cerca de los dispositivos finales, pero aún dentro de la red. El ‘fog computing’ proporciona mayor flexibilidad y eficiencia al repartir la carga de trabajo entre los dispositivos ‘edge’ y los centros de datos en la nube [2]. Esta arquitectura es útil en situaciones que requieren una combinación de baja latencia, procesamiento local y la capacidad de aprovechar recursos escalables en la nube, sin depender completamente de ella.

El ‘cloud computing’ proporciona servicios como servidores, almacenamiento y bases de datos a través de Internet. Su principal ventaja es la capacidad de ofrecer recursos casi ilimitados bajo demanda, lo que permite a las empresas escalar sus operaciones sin grandes inversiones en infraestructura física. Sin embargo, puede tener una mayor latencia, ya que los datos deben viajar hasta centros de datos remotos para su procesamiento. Este modelo es más adecuado para aplicaciones que no requieren respuestas en tiempo real o que gestionan grandes volúmenes de datos a largo plazo.

En estos sistemas de procesamiento distribuidos, la latencia y escalabilidad varían notablemente entre las tres capas. Los dispositivos ‘edge’, situados cerca del origen de los datos, tienen latencias de milisegundos. Los servidores ‘fog’, ubicados en centros de datos locales, presentan una latencia moderada adecuada para muchas aplicaciones. En contraste, la nube, con servidores distribuidos globalmente, puede experimentar mayores retrasos, especialmente si los datos deben recorrer largas distancias, como entre continentes o países distantes.

Estas diferencias en latencia también se reflejan en la capacidad de cómputo de cada capa [3]. Los dispositivos ‘edge’ pueden ir desde soluciones simples, como una Raspberry Pi, hasta servidores de alto rendimiento instalados cerca de las máquinas industriales para un procesamiento rápido y local. Los servidores fog abarcan desde configuraciones básicas para tareas locales hasta complejas instalaciones de racks con múltiples servidores que procesan grandes volúmenes de datos antes de enviarlos a la nube. Finalmente, la nube ofrece una escalabilidad casi ilimitada, aunque con mayores latencias. La Tabla 1 resume las características clave de estas tres capas, incluyendo su latencia, escalabilidad, distancia y los dispositivos involucrados.

Muchas empresas, especialmente aquellas que manejan información sensible, y a pesar de los grandes avances en ciberseguridad, evitan el uso exclusivo del ‘cloud computing’ debido a los riesgos de exposición a Internet, como ciberataques y accesos no autorizados. Aunque la nube ofrece una infraestructura escalable y avanzada, el hecho de que los datos viajen a través de redes públicas conlleva riesgos significativos, como la interceptación de datos y las brechas de seguridad en centros de datos remotos [4]. Para las organizaciones que deben cumplir con estrictas normativas de privacidad o que manejan información confidencial, estos riesgos son decisivos para evitar el uso exclusivo de la nube.

Como alternativa, muchas empresas optan por ‘fog’ o ‘edge computing’ para mantener un mayor control sobre la seguridad de sus datos, aunque es importante señalar que estas arquitecturas tampoco están exentas de ataques externos. En el ‘fog computing’, los datos se procesan y almacenan más cerca de su origen, permitiendo a las empresas aplicar políticas de seguridad más estrictas y adaptadas a sus necesidades [5]. El ‘edge computing’ lleva esto aún más lejos al procesar los datos directamente en el dispositivo final, reduciendo casi por completo la necesidad de enviar información fuera de la red local. De esta manera, las empresas pueden proteger mejor su información sensible, manteniéndola dentro de su propia infraestructura y minimizando el riesgo de comprometerla durante el tránsito hacia centros de datos remotos.

Infraestructura de fog computing en el CFAA

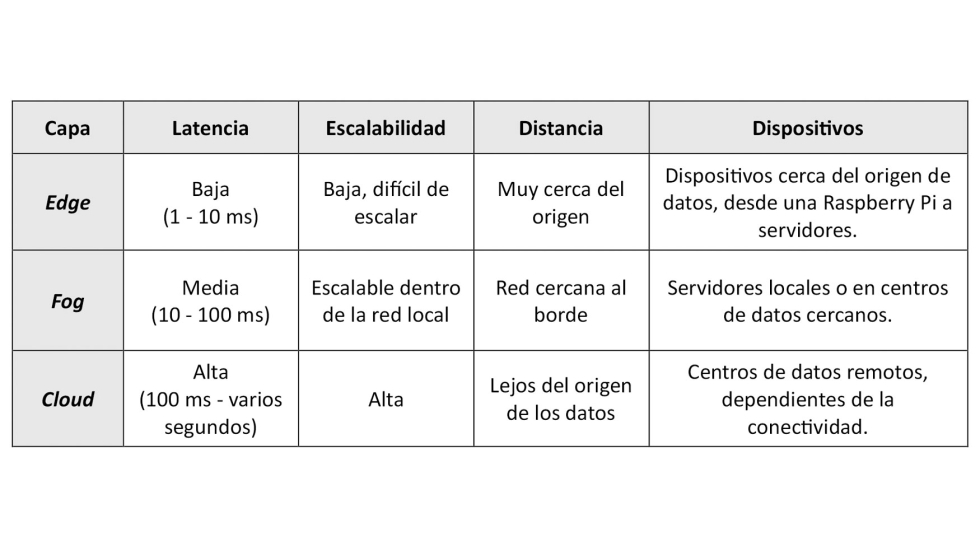

En el Centro de Fabricación Avanzada Aeronáutica (CFAA) [6] se ha implantado una solución basada en ‘fog computing’ de la mano de Savvy Data Systems [7]. Esta empresa se especializa en apoyar la transformación digital de empresas industriales, convirtiendo sus datos en información útil para el negocio. Además, ofrece servicios avanzados en monitorización, análisis de datos e inteligencia artificial y trabaja junto a centros de investigación para mantenerse a la vanguardia de las tecnologías digitales en el sector de la fabricación.

La solución implantada, denominada Savvy Fog [8], facilita la gestión y procesamiento local de los datos generados por las máquinas, manteniendo la información sensible dentro de la propia infraestructura y evitando su exposición a Internet. Esta plataforma avanzada permite manejar grandes volúmenes de datos en tiempo real, reduciendo la latencia y optimizando el uso de recursos en entornos complejos.

Savvy Fog permite la captura y gestión de datos de nueve máquinas-herramienta monitorizadas en el CFAA, como se ilustra en la figura 2. Cada máquina está equipada con un dispositivo ‘edge’ (Savvy SmartBox) conectado al Savvy Fog ubicado dentro del CFAA. Esta configuración no solo ofrece un mayor control sobre la propiedad y gestión de los datos, sino que también garantiza la interoperabilidad con otros sistemas para la importación y exportación de datos.

Caso de uso: visualización de datos de consumo de máquinas

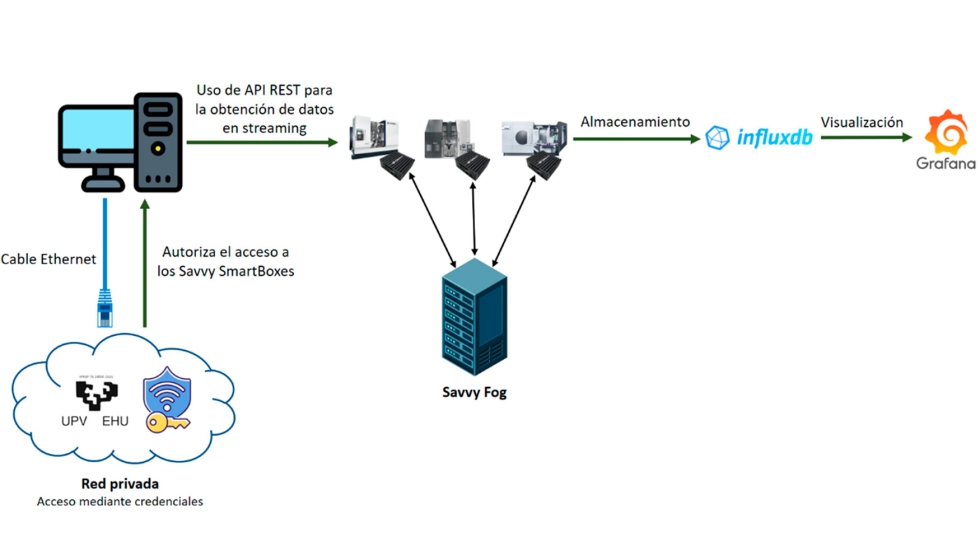

La optimización del consumo energético es un aspecto clave para mejorar la productividad y reducir los costos operativos en entornos de fabricación como el CFAA. En un escenario donde la automatización y la digitalización están en constante crecimiento, disponer de herramientas avanzadas como Savvy Fog es crucial para mantener un control total sobre los datos en tiempo real. Este caso de uso muestra cómo la integración de tecnologías de ‘fog computing’, bases de datos y herramientas de visualización transforma la gestión de recursos, permitiendo la captura y análisis de datos sobre el consumo energético para tomar decisiones estratégicas que optimicen el consumo y reduzcan el impacto ambiental de las fabricaciones. En este caso de uso, un equipo conectado a una red local y autenticado correctamente puede enviar una solicitud a la API REST de Savvy para acceder a los datos de consumo energético de las máquinas del CFAA, habilitando así la interoperabilidad de datos en ‘streaming’. Como se ilustra en la figura 3, los datos transmitidos desde los SmartBoxes se almacenan en una base de datos de series temporales (InfluxDB en este caso), diseñada para gestionar grandes volúmenes de datos de manera eficiente. La visualización de estos datos se realiza a través de Grafana, que efectúa consultas a InfluxDB y presenta los resultados en un cuadro de mandos mediante paneles, facilitando a los operadores de planta el análisis intuitivo de la información.

Desde el punto de vista de los usuarios, el acceso al sistema Savvy Fog requiere autenticarse con credenciales específicas, garantizando que solo el personal autorizado pueda ingresar a la red local. A través de una conexión Ethernet, es necesario habilitar puertos específicos para activar las funcionalidades de los SmartBoxes. Tras completar estos procedimientos, los usuarios pueden interactuar con los dispositivos ‘edge’, permitiendo la extracción de datos en ‘streaming’, el despliegue de algoritmos, la actualización de aplicaciones y la visualización en tiempo real del estado de las máquinas.

Además, al disponer de datos en tiempo real sobre el consumo energético de cada máquina, se puede incorporar información externa, como el precio diario de la energía eléctrica, obtenido de una API [9]. El precio de la electricidad en España fluctúa según varios factores, como la demanda general de energía, el coste de generación y las condiciones climáticas. De esta manera, se pueden ajustar los tiempos de operación para coincidir con las horas de menor costo energético, lo que resulta en un ahorro en las operaciones diarias de la planta. En la figura 4 se muestra un ejemplo de un panel de Grafana, donde se puede visualizar el precio por hora del kilovatio, el consumo instantáneo de cada máquina, así como el consumo y el costo total mensual de las máquinas en la planta del CFAA.

Conclusiones y trabajo futuro

La combinación de computación ‘edge’ y ‘fog’ permite organizar de manera eficiente la recogida, procesamiento y visualización de datos en tiempo real, optimizando el uso de los recursos y reduciendo la latencia en entornos industriales. En el CFAA, hemos implementado este enfoque en un caso de uso centrado en la monitorización del consumo energético de las máquinas, lo que nos ha permitido mejorar la eficiencia operativa y facilitar la toma de decisiones basada en datos.

Como parte de los pasos futuros, se contempla el despliegue de algoritmos de aprendizaje federado para mejorar el consumo energético de las máquinas. El aprendizaje federado permite entrenar modelos de aprendizaje automático de manera distribuida, donde múltiples nodos ejecutan algoritmos de IA localmente. Los resultados de estos entrenamientos se consolidan en un modelo central, que optimiza y gestiona el funcionamiento de cada nodo de manera eficiente. Este enfoque permite que los modelos se ajusten a las características específicas de cada nodo sin compartir datos sensibles, garantizando la privacidad y seguridad de la información.

En la práctica, se asignará un nodo a cada máquina-herramienta, cada uno ejecutando un algoritmo de IA basado en datos históricos y en tiempo real sobre el consumo energético. Mientras las máquinas realizan sus tareas, se recogerán lecturas energéticas para predecir el consumo asociado a distintos programas. La eficacia de estas predicciones se evaluará mediante la comparación de los consumos estimados con los reales. Los resultados de cada nodo se integrarán en un modelo central, utilizando herramientas como TensorFlow Federated [10] o Flower [11], que gestionará las recomendaciones para la ejecución óptima de programas en las máquinas, maximizando la eficiencia energética y reduciendo costos.

Endika Tapia Fernandez. investigador del Centro de Fabricación Avanzada Aeronáutica. Ingeniero informático en Gestión y Sistemas de Información en la Universidad del País Vasco. Su área principal de investigación es la computación paralela y distribuida, con especial atención a los siguientes temas: computación de alto rendimiento, sistemas de procesamiento de datos escalables y protocolos de comunicación industrial y conectividad.

Leonardo Sastoque Pinilla, investigador del Centro de Fabricación Avanzada Aeronáutica.

Doctor en Ingeniería de proyectos enfocado en el uso de herramientas de Inteligencia Artificial a la gestión de proyectos 4.0, Máster en dirección de proyectos europeos e ingeniero aeronáutico. Está especializado en la gestión y desarrollo de proyectos de transformación digital e implementación de tecnologías 4.0. Cuenta con experiencia en ingeniería de procesos y proyectos, e implementación de sistemas de gestión.

Unai López Novoa, profesor Agregado en el Departamento de Lenguajes y Sistemas Informáticos de la Universidad del País Vasco.

Imparte docencia en el Grado en Ingeniería Informática de Gestión y Sistemas de Información de la Escuela de Ingenería de Bilbao. Su área principal de investigación es la computación paralela y distribuida, con especial interés en sistemas de datos escalables y eficiencia energética.

Referencias

[1] Hazra, A., Rana, P., Adhikari, M., & Amgoth, T. (2023). Fog computing for next-generation Internet of Things: fundamental, state-of-the-art and research challenges. Computer Science Review, 48, 100549.

[2] S. Delfin, N. P. Sivasanker., N. Raj and A. Anand, “Fog Computing: A New Era of Cloud Computing, ” 2019 3rd International Conference on Computing Methodologies and Communication (ICCMC), Erode, India, 2019, pp. 1106-1111, doi: 10.1109/ICCMC.2019.8819633.

[3] Firouzi, F., Farahani, B., & Marinšek, A. (2022). The convergence and interplay of edge, fog, and cloud in the AI-driven Internet of Things (IoT). Information Systems, 107, 101840.

[4] Ometov, A.; Molua, O.L.; Komarov, M.; Nurmi, J. A Survey of Security in Cloud, Edge, and Fog Computing. Sensors 2022, 22, 927. https://doi.org/10.3390/s22030927.

[5] Rani, S., & Srivastava, G. (2024). Secure hierarchical fog computing-based architecture for industry 5.0 using an attribute-based encryption scheme. Expert Systems with Applications, 235, 121180.

[6] CFAA. https://cfaa.eus/. Accedido el 09/09/2024.

[7] Savvy Datasystems. https://www.savvydatasystems.com/es/plataforma-iiot/plataforma-industrial-iot. Accedido el 06/09/2024.

[8] Savvy Fog en el CFAA. https://www.fernandosaenz.com/savvy-fog-potencia-al-centro-de-fabricacion-avanzada-aeronautica-cfaa-en-el-campo-de-la-inteligencia-artificial/. Accedido el 04/09/2024.

[9] API del precio de la luz. https://api.preciodelaluz.org/. Accedido el 04/09/2024.

[10] TensorFlow Federated. https://www.tensorflow.org/?hl=es. Accedido el 09/09/2024.

[11] Flower. https://flower.ai/. Accedido el 09/09/2024.