FATIMA: Fabricación Avanzada y Técnicas de Inteligencia Artificial en las Máquinas

En el presente trabajo se ha seleccionado una problemática concreta relacionada con la selección de parámetros para un nuevo programa de mecanizado y unas condiciones de acabado determinadas. Para ello, se han simulado en vacío más de 100 programas cada uno de ellos con 4.200 configuraciones diferentes. En total se han generado más de 3 Terabytes de datos. También se han definido las funciones objetivo a optimizar, las cuales han sido el error geométrico, el tiempo y la suavidad. El tiempo y el error geométrico se pueden estimar directamente en los resultados de las ejecuciones, pero para poder estimar el acabado superficial se han definido y calculado diferentes indicadores (KPI) para cada pareja programa-actuador, conformando una base de conocimiento del comportamiento de los actuadores para diferentes tipos de programas. Cuando se deba seleccionar el actuador idóneo para un programa de mecanizado hasta ahora desconocido, se usará un mecanismo capaz de buscar sus similitudes respecto a los programas de mecanizado en la base de conocimiento. Esta similitud vendrá definida en función de la trayectoria de ambos programas. Seleccionando uno o varios programas de mecanizado similares en la base de conocimiento, será posible realizar recomendaciones al usuario sobre el uso de determinados actuadores. Los actuadores recomendados serán aquellos en que los programas más parecidos tuvieron unos resultados en las simulaciones que permite prever un comportamiento en términos de tiempo, error geométrico y suavidad, acorde a las restricciones introducidas por el usuario para el nuevo programa de mecanizado.

1. Introducción

El presente trabajo describe un problema real, común en controles numéricos, cuando se enfrentan con la necesidad de optimizar el tiempo de ejecución de una pieza, típicamente obtenida a partir de programas de CAD-CAM, compuesta de muchos bloques de movimiento pequeños. Todos los controles numéricos utilizan estrategias de look-ahead para tener en cuenta multitud de bloques de programa sin parar en los puntos intermedios. Estas estrategias contienen a menudo heurísticas complejas y puede modificarse su comportamiento mediante una serie de parámetros. El conjunto de técnicas de interpolación para conseguir la máxima velocidad posible cuando se debe seguir una trayectoria dividida en bloques diminutos se denomina HSC (High Speed Cutting). Una adecuada selección de los parámetros permite obtener comportamientos más precisos a menos velocidad o más veloces, pero sacrificando parcialmente la precisión. Sin embargo, a pesar de que las parametrizaciones por defecto son adecuadas para casos comunes, existen muchas ocasiones en que una mayor dedicación a experimentar con los parámetros conduce a resultados más precisos, más suaves o con menor tiempo de ejecución. La naturaleza parcialmente heurística de los algoritmos y la influencia del comportamiento de la máquina (dinámica, efectos no-lineales en las inversiones…) hacen que no exista una relación lineal ni simple entre los conceptos parametrizados y los resultados obtenidos.

Habida cuenta de que una inversión de tiempo en pruebas con diferentes conjuntos de valores ha conllevado en numerosas ocasiones una mejora de los resultados, y que técnicos experimentados son capaces de conseguir estos resultados de forma más eficiente, resulta natural preguntarse si este proceso mental, interiorizado en los usuarios cualificados, puede conseguirse de forma automática o mecanizada, bien entendido que conocemos la naturaleza no-lineal que subyace en la algoritmia involucrada en el look-ahead.

El objeto principal del proyecto ha sido analizar la idoneidad de diferentes técnicas de Inteligencia Artificial cuando se aplican en el entorno de máquina-herramienta, proporcionando una clasificación general y una solución más específica en los casos que se contemplan en el proyecto. Además, para los problemas considerados, se obtendrán algoritmos de optimización concretos que aporten una solución eficiente al problema. Y dentro del esquema general de los algoritmos de IA, planteamos utilizar aquellos que se basan en el tratamiento de grandes cantidades de datos.

El concepto Big Data, transferido de las tecnologías IT aplicadas a datos masivos como los obtenidos en la navegación por internet, viene definido no solamente por el volumen de datos manejados y las estructuras físicas y lógicas que los soportan, lo que ya es en sí mismo un problema, sino por su velocidad, complejidad y heterogeneidad. Estas condiciones se cumplen claramente en el caso de las màquines-herramienta y los datos obtenidos de los sensores.

El planteamiento general del problema es el siguiente:

Disponemos de un conjunto de programas pieza con diversas problemáticas acumulado a lo largo del tiempo. Estos programas poseen características que a un usuario experto le permitirían clasificarlos de alguna manera como más ‘difíciles’ o más ‘suaves’ o incluso detectar características conflictivas dentro de su geometría. En función de esta evaluación pueden elegirse conjuntos de parámetros idóneos a priori para obtener unos objetivos determinados (calidad superficial, precisión, tiempo mínimo) o una mezcla ‘óptima’ de los mismos, donde este valor lo determina el usuario final. Como hemos dicho anteriormente, cuando las piezas tienen zonas problemáticas, la parametrización por defecto puede no ser óptima (por ejemplo, se obtiene una pieza de gran calidad, pero tardando mucho) y hay que acudir a retocar los valores ajustados. Esto resulta en ocasiones frustrante para el usuario porque se requiere un grado de experiencia importante para realizar un ajuste correcto. A esto hay que añadir que, como se ha dicho, para programas diferentes los parámetros óptimos pueden ser también muy diferentes porque contienen problemas específicos como frecuencias espaciales altas, errores en los puntos programados generados por el CAD-CAM (mucho más frecuente de lo esperado) o la precisión no es la adecuada.

El objetivo general ha sido dar solución a este problema en sus dos vertientes: por un lado, en cuanto a ajuste de los parámetros de HSC, que deben ser óptimos para un programa pieza y una máquina determinada, pues la misma pieza en otra máquina podría requerir ajustes ligeramente diferentes. Por otro lado, obtener y mantener el modelo necesario de esta máquina para que los parámetros calculados tengan resultados homogéneos.

De alguna manera, el proyecto debe obtener un algoritmo capaz de encontrar patrones en los programas tipo, de forma que se obtenga un clasificador (implícito o explícito) por la mera lectura del mismo. Este clasificador o reconocedor de patrones puede obtenerse por varias técnicas, como se verá más adelante, pero debe realimentarse por los resultados de los algoritmos de HSC sobre los programas tipo. El encuadre de la problemática y el planteamiento general, al que se da respuesta en los apartados posteriores es el siguiente:

Tenemos un conjunto amplio de programas pieza y la geometría, tanto teórica como ‘real’ obtenida en la simulación en el CNC. Se tratará de un conjunto importante de datos, pues cada programa pieza se simulará con diferentes conjuntos de parámetros de HSC y diferentes modelos de máquina, en esta fase modelos simples lineales.

Los datos, aunque se obtendrán en un entorno de simulación, son datos reales. Esto es importante destacarlo, lo que buscamos es una optimización de unos algoritmos cuya salida real como respuesta a una serie de parámetros de entrada y un programa dado, podemos conseguirlo sin necesidad de ejecutarlos en tiempo real.

Para cada uno de los resultados obtenidos con un programa y un set de parámetros, se deben establecer indicadores, figuras de mérito, funciones de coste… y encontrar algoritmos que minimicen esos valores en el conjunto de trabajo.

Puesto que anticipamos que el ajuste de la máquina y la dinámica de la misma influyen obviamente en los resultados de mecanizado (tanto en los tiempos como, sobre todo, en la calidad), simularemos los accionamientos como sistemas de segundo orden con varias frecuencias de resonancia y amortiguamientos dentro del rango típico de màquines-herramienta.

Y para este conjunto de programas multiplicado por el conjunto de parámetros (actuadores) y multiplicado a su vez por el grupo de frecuencias y amortiguamientos seleccionados, debemos calcular figuras de mérito, indicadores, evaluaciones… que nos permitan clasificar los resultados.

Esta clasificación de los resultados se retroalimentará hacia los algoritmos de clasificación para obtener un algoritmo ‘ganador’.

El algoritmo o algoritmos candidato se verificará con conjuntos diferentes de programas y modelos para validarlo y establecer su robustez. La fase final es la ejecución de dicho algoritmo en el CNC de una máquina, de forma que ante un nuevo programa nos proporcione un conjunto de parámetros para dicho programa, para esa máquina y para el criterio de bondad elegido.

Idealmente, este algoritmo incluirá medios para evolucionar de forma autónoma y seguir aprendiendo a partir de sucesivas ejecuciones de programas.

2. Estado del arte. Inteligencia Artificial

Existen estudios sobre patrones de aprendizaje y su clasificación o definición de características según el problema a atajar para ambientes inteligentes. En su trabajo [1], Aztiria pone de manifiesto el problema de que todas las técnicas de ‘Machine Learning’ no sirven para dar solución a todos los problemas. Aztiria considera las siguientes técnicas de Machine Learning y propone una clasificación para entornos inteligentes:

- Redes Neuronales Artificiales

- Técnicas de Clasificación

- Reglas de Lógica Difusa

- Descubrimiento de Secuencias

- Aprendizaje basado en instancias

- Aprendizaje Reforzado

Cada una de las técnicas de Machine Learning tiene sus puntos fuertes y débiles. Diferentes análisis y la experiencia dicen que, para diferentes problemáticas, se usan diferentes técnicas.

Actualmente no existe una clasificación o enfoque global donde están definidas las técnicas a usar en cada tipo de problema para dar respuesta a los diferentes problemas en el ámbito de manufacturing. Además, parece que la solución seguramente no sea el uso de una sola técnica en cada uno de los problemas, sino que seguramente se necesite de combinaciones de técnicas. Para entornos inteligentes, este ha sido el enfoque por el que apuestan.

2.1. Métodos de Selección de Variables

A continuación, se describen las diferentes técnicas presentes en cuanto a selección de variables clave de proceso. Se consideran tres clases de técnicas.

a) Técnicas univariadas

Técnicas empleadas para realizar la selección de variables de manera individual, es decir, sin tener en cuenta las interacciones y redundancias que pueden mostrar con otros conjuntos de variables. Entre ellas, se consideran como más interesantes las siguientes:

- Técnicas basadas en correlación (Pearsoncorrelación lineal, Spearman- correlación no lineal, Kendall-no paramétrica): A fin de determinar la correlación con respecto a una variable discreta no ordinal se emplea la información mutua, medida basada en la teoría de la información [3]. Dicha medida es no paramétrica y tiene interpretaciones en término de dependencia entre variables aleatorias. Mide la reducción media en la incertidumbre de la variable que se quiere predecir o estimar (KPI) al conocer el estado de una segunda variable.

- Técnicas basadas en test estadísticos (Test estadísticos paramétricos y no paramétricos): En los test estadísticos se aplican algunos de los coeficientes de correlación previamente descritos tal como el coeficiente de correlación de Pearson o la información mutua. El uso de test estadísticos permitirá establecer la significatividad de los coeficientes de correlación estimados.

b) Técnicas multivariadas

Una vez realizado el estudio para la detección de variables de forma univariada, se amplía el estudio mediante la detección de conjuntos de variables altamente correlacionadas con las diferentes variables KPI. El uso de técnicas univariadas permitirá reducir el conjunto de variables consideradas por las técnicas multivariantes. Se diferencian dos grupos de técnicas: las basadas en teoría de la información [2, 3, 7, 13] y las basadas en técnicas de envoltura (Wrappers) [8].

- Técnicas basadas en la teoría de la información: se emplearán dos técnicas para la detección de subconjuntos de variables empleando medidas provenientes en la teoría de la información. Ambas técnicas consisten en una medida que tiene en cuenta la correlación con la variable KPI de cada una de las variables seleccionadas, así como una medida de la redundancia entre las mismas. La principal suposición tras la selección basada en teoría de la información radica en que un buen conjunto de variables es aquel que está fuertemente correlacionado con la variable de interés y poco correlacionado entre si [2, 7]. Para ello se emplean marcadores tales como la medida de selección basada en correlación (Correlation based Feature Selection, CFS [7]) y medidas provenientes del marco propuesto por Brown et al. en [2].

- Debido al número exponencial de posibles subconjuntos de variables se necesita emplear algún algoritmo de búsqueda aproximado. En este estudio se emplean como meta-heurísticas de búsqueda el uso de los algoritmos genéticos (Genetic Algorithms, GA [5, 15]) y algoritmos de estimación de distribuciones (Estimation of Distribution Algorithms, EDA [8, 11])

- Técnicas Wrapper: Esta aproximación emplea un clasificador (o regresor) como medida de la bondad de un subconjunto de variables. Es decir, el error que comete un clasificador construido con un subconjunto de variables será empleado como medida de la bondad de dicho subconjunto de variables. Esta técnica asume que un buen conjunto de variables es aquel mediante el cual se puede realizar una buena predicción de la variable KPI. Para ello es conveniente emplear algoritmos de clasificación (o regresión) con buenas propiedades teóricas, i.e. consistencia asintótica, tales como las máquinas de soporte vectorial (Support Vector Machines, SVM [4, 6, 14, 15]).

c) Remuestreo, ranking y consensuado de características

Por último, se consideran tres técnicas de carácter general que combinadas permiten determinar las características más prominentes [10]. Dichas técnicas permitirán combinar resultados parciales a fin de conseguir una selección de subconjuntos de variables más robusta y menos sensible al ruido particular de cada base de datos.

2.2. Analítica de Datos en Manufacturing

La obtención de un algoritmo de optimización, se puede llevar a cabo mediante la utilización de diferentes técnicas de Inteligencia Artificial (IA) o una combinación de ellas. A continuación, se define el estado del arte de esta tecnología. La IA replica tanto los procesos de razonamiento humano como su comportamiento y además construye máquinas capaces de simular la toma de decisiones humana en entornos imprecisos y no certeros [17]. Dentro de las técnicas de IA, con el objetivo de obtener conocimiento (patrones válidos) de los datos recogidos en el proceso de fabricación, se utilizan los Knowledge Discovery in Databases (KDD). Los KDDs son procesos no triviales de identificación de patrones válidos y entensibles partiendo de datos. Data Mining es una aplicación de unos algoritmos específicos para extraer dichos patrones (modelos) de los datos y es un paso particular del proceso KDD [18, 19]. Estos últimos años, se han aplicado muchas técnicas de Data Mining en el dominio de fabricación:

Sistemas Experto Basado en Reglas [20, 21, 22, 23, 24], Redes Neuronales [25, 26, 27, 28, 29, 30], Reglas de Asociación [31], Razonamiento Basado en Casos [32, 33, 34, 35, 36, 37] o Fuzzy Logic [38, 39, 40, 41]. Todos ellos han mostrado un gran potencial cuando se han utilizado en el desarrollo de sistemas inteligentes para el control, pero los resultados obtenidos han sido muy orientados a problemas muy específicos.

En realidad, la optimización aplicada a procesos de mecanizado ha aparecido repetidamente en la literatura. Muchos de ellos se han concentrado en cómo se ha llevado a cabo el proceso, por ejemplo, en [43] se utilizó una aproximación multiobjetivo para mitigar los niveles de vibración y mantener la calidad de la superficie mientras se mantenían tiempos de producción y se decrementaba el desgaste de herramienta. El material usado para los experimentos era AA 6082-T6.

Li et al. en [44] presentan un análisis de los parámetros de corte y su efecto en procesos de mecanizado. Utilizan métodos de análisis estadístico con el objetivo de analizar la relación entre el consumo energético y tiempo de producción. Los elementos considerados en dicho análisis son las potencias auxiliares, potencia en vacío, potencia para retirada de material y pérdidas adicionales. El proceso completo de mecanizado es, por lo tanto, dividido en 7 periodos: a) startup, b) standby, c) spindle acceleration/deceleration, d) spindle idle, e) rapid feed, f) cutting and g) air cutting periods.

Con el objetivo de introducir mayores niveles de independencia en las máquinas CNC, [48] calcula la secuencia óptima de controles para una trayectoria de la herramienta, para una geometría de la herramienta dada y tipo de material que se desea mecanizar. Se simula el proceso, encuentra la solución óptima y reconstruye los estados teniendo en cuenta la rugosidad de la superficie. En [49] se considera el fresado ortogonal, donde se seleccionan como parámetros las velocidades rotacionales y del cabezal, excentricidad herramienta-trabajo, profundidad de pasada y avance por revolución. Lo que se analiza es el efecto de cada parámetro en el desgaste de herramienta, la rugosidad superficial, cantidad de material eliminado y las fuerzas de corte. Se usó un algoritmo genético para identificar las soluciones en la frontera de Pareto.

3. Desarrollo del sistema experto FATIMA

La obtención de la base de conocimiento era el requisito indispensable para el éxito de la tarea de definir un sistema experto basado en reglas capaz de determinar valores de actuadores adecuados al programa de mecanizado y ajustado a criterios de tiempo, error geométrico y suavidad preestablecidos por el usuario del CNC. Los ingredientes de este sistema experto son la base de conocimiento de 108 programas, hasta el momento, y su respuesta a cada uno de los 4.200 actuadores además del análisis de dicha respuesta en términos de las funciones objetivo a considerar: suavidad, tiempo y error geométrico.

Para la base de conocimiento se ha generado un conjunto de programas pieza de cliente que han sido unificados en cuanto a prestaciones programadas de forma que el contenido de los mismos sólo representa la parte puramente geométrica, es decir, se han filtrado las instrucciones que corresponden a gestión del almacén de herramientas, gestión del cabezal, etc. El CNC, de forma natural, o incluso en modo simulado, no dispone de una salida textual que permita capturar las posiciones generadas por el interpolador y enviadas a los lazos de regulación, y mucho menos las posiciones intermedias antes y después de los posibles filtros, etc. Se ha modificado el código fuente del CNC en modo simulador de forma que nos proporcione, para este proyecto en concreto, la información solicitada y en formato ASCII. La modificación de cada uno de los actuadores mediante la instrucción asociada en el CNC nos da un escenario de ajuste de máquina que permite ejecutar y obtener resultados para todos los programas (108) con todos los actuadores (4200) relacionados con porcentajes de aceleración y jerk (considerados 5 diferentes) de 3 ejes, de tolerancia geométrica (considerados 6 diferentes), filtro de trayectoria (4), filtro de eje (5) y modo de mecanizado (7). Los algoritmos de generación de trayectoria proveen datos teóricos diferentes en función de los actuadores. En relación a las funciones objetivo de suavidad que deberá medirse de manera indirecta, se procede a definir indicadores clave de rendimiento relacionados con el concepto de suavidad, tales como indicadores unidimensionales espacio-temporales que recontaran fenómenos tales como:

- Lóbulos positivos de aceleración de trayectoria

- Lóbulos negativos de aceleración de trayectoria

- Lóbulos inversión de aceleración de trayectoria

- Lóbulos aceleración eje

- Inversiones de lóbulos aceleración eje

- Lóbulos jerk eje

- Inversiones de lóbulos de jerk

- Tiempo entre picos de aceleración

- Tiempo entre picos de jerk

- Ciclos sobrepasamiento accel eje

- Ciclos sobrepasamiento jerk eje

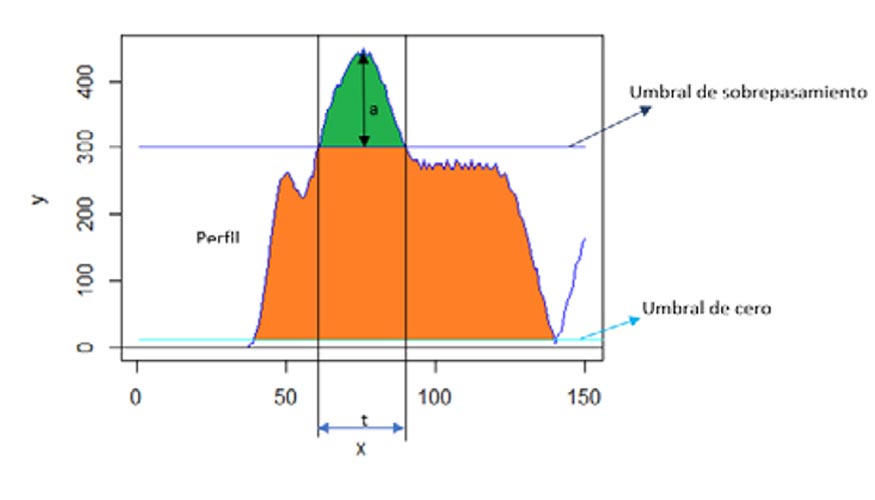

Cada uno de estos indicadores ha sido definido exhaustivamente tal como se puede apreciar en la figura 1 correspondiente a sobrepasamientos.

Es de resaltar el coste computacional asociado al cálculo detallado de dichos indicadores no debiendo descartar aproximaciones a los valores exactos siempre que el recuento tenga como cota superior el número real de recuentos de cada fenómeno.

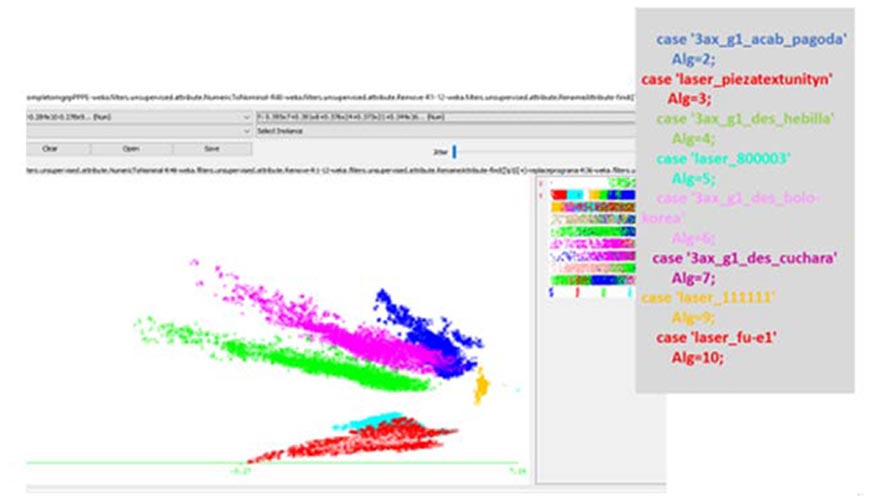

Valores reales o sus aproximaciones pueden usarse para obtener proyecciones, por ejemplo, con el análisis de componentes principales, que permitan discriminar diferentes programas de mecanizado en base al concepto de suavidad. La siguiente figura 2 es una muestra de ello.

En lo que respecta al error geométrico, se calcula de forma temporal la desviación geométrica de las cotas reales de cada ejecución del programa pieza, respecto a la trayectoria teórica programada. En lo que respecta al tiempo, es suficiente con contar las líneas de los ficheros de salida producidos por el simulador CNC. Para la obtención de las cotas teóricas patrón se han utilizado condiciones extremas de mecanizado (avance muy bajo, paso exacto por las cotas programas, etc.).

Para que el sistema experto admita como entrada un programa de mecanizado desconocido y dé como respuesta la selección de actuadores que mejor se ajuste a los requerimientos establecidos previamente, es necesario, además, caracterizar los programas. La caracterización de los programas se deberá hacer sobre las cotas teóricas anteriormente mencionadas, pudiendo usarse primeras y segundas derivadas espaciales para extraer estadísticos tales como media, mediana, máximos, mínimos, varianzas, apuntamiento, etc., o bien utilizando conceptos tales como radio de curvatura (definida como el inverso del valor absoluto de la curvatura en cada punto). A continuación, el sistema experto identificará en ese programa o conjunto de programas similares los actuadores que cumplan los requisitos establecidos previamente.

El proceso de validación deberá por lo tanto asegurar que los actuadores ofrecen resultados en tiempo, error geométrico y suavidad que se encuentran correlacionados para programas caracterizados como semejantes resultados. Como proceso de validación, se han escogido 3 nuevos programas (prog_1, prog_2, prog_3). Por una parte, se les ha aplicado el algoritmo de caracterización de programa para buscar aquella que se le asemeje más y escoger el actuador que le corresponde y, por otra parte, se han simulado para los 4200 actuadores y calculado sus KPIs. De esta manera es posible valorar la respuesta del sistema experto observando si los actuadores elegidos por semejanza a otros programas tendrán un comportamiento como el esperado.

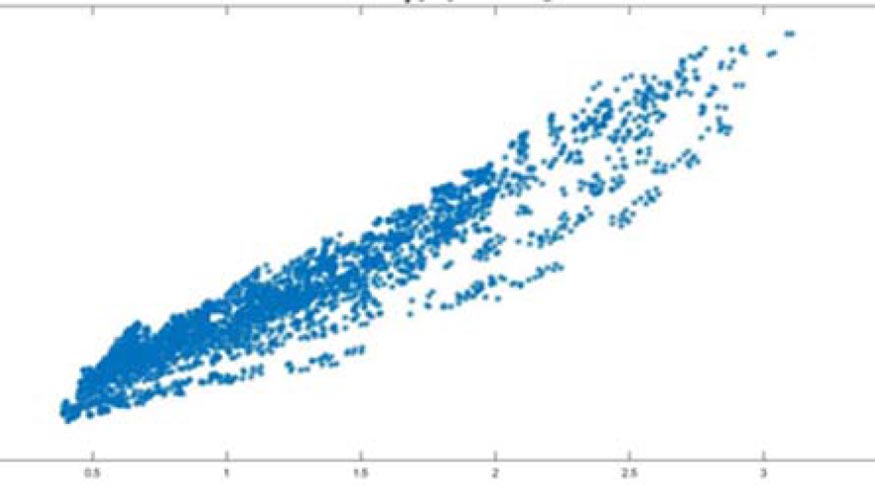

Para comparar comportamientos similares entre programas en relación al concepto de suavidad, se utiliza el coeficiente de correlación para los 4.200 actuadores. Se muestra a continuación la gráfica de pares de valores de distancias al origen de la suavidad para un programa nuevo y su semejante. Tal como se puede ver, cada vez que la suavidad aumenta en uno de los programas para un actuador, aumenta también en el otro programa para el mismo actuador. Se podría decir que el criterio de suavidad que se ha implementado recoge bien el criterio de similitud empleado, radio de curvatura.

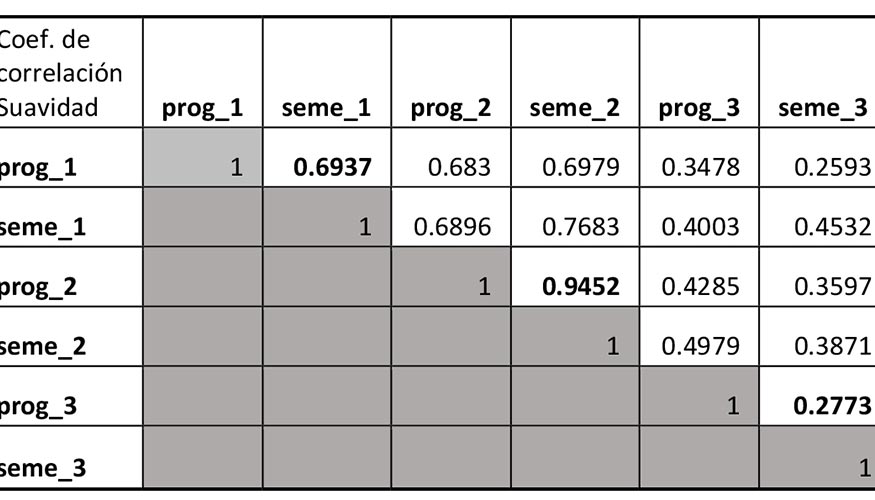

A continuación, podemos observar todas las correlaciones encontradas para la suavidad entre los 6 programas considerados en el proceso de evaluación (3 programas nuevos, prog_1, prog_2, prog_3 y los 3 programas en la base de conocimiento semejantes a los anteriores, seme_1, seme_2, seme_3).

Hay que indicar que el resultado del programa prog_3 no se pueden considerar como definitivo. Esto es debido a que el programa es largo y complejo y no se han considerado los 4.200 actuadores en la fase de validación (se han considerado 1.425 actuadores en lugar de 4.200). En los otros dos casos, se ha visto que el proceso de validación ha servido para confirmar que el método investigado y presentado como resultado en el proyecto es satisfactorio ya que se puede observar que el programa elegido en el proceso de caracterización de programas corresponde con los que más correlación tiene en los KPIs correspondientes a suavidad.

4. Conclusiones y líneas futures

Como consecuencia del trabajo realizado, ahora es posible clasificar cualquier programa pieza y seleccionar los parámetros máquina adecuados, para que la suavidad, el tiempo de mecanizado y la geometría obtenida sean óptimos según los requisitos establecidos por el usuario. Los resultados, dejan entrever la posibilidad de aplicar diferentes técnicas de IA al proceso de corte de chapa por láser, incluyendo desde el análisis del programa a realizar, hasta las estrategias de corte en función del material, pasando por el ajuste óptimo de los accionamientos para cada pieza en una máquina dada, extendiendo de esta manera el rango de aplicación desde la pura generación de trayectoria (descrito en este trabajo) a la optimización de los parámetros de ajuste de los accionamientos y al propio proceso del corte (potencias idóneas, introducción de la variabilidad de la chapa en cuanto a materiales y espesores…).

Reconocimientos

La financiación para la realización de este proyecto de investigación (FATIMA, KK-2015/000Ú) ha sido concedida por el programa Elkartek del Gobierno Vasco / Eusko Jaurlaritza.

Referencias

[1] A. Aztiria, A. Izaguirre, J.C. Augusto (2010). Learning patterns in ambient intelligence environments: a survey. Artificial Intelligence Review. Vol. 34. N° 1. Pp 35-51.

[2] Brown, G., Pocock, A., Zhao, M. J., & Luján, M. (2012). Conditional likelihood maximisation: a unifying framework for information theoretic feature selection. The Journal of Machine Learning Research, 13(1), 27-66.

[3] Cover, T. M., & Thomas, J. A. (2012). Elements of information theory. John Wiley & Sons.

[4] Chen, Y. W., & Lin, C. J. (2006). Combining SVMs with various feature selection strategies. In Feature extraction (pp. 315-324). Springer Berlin Heidelberg.

[5] Goldberg, D. E. (2006). Genetic algorithms. Pearson Education India. [6] Guyon, I., & Elisseeff, A. (2003). An introduction to variable and feature selection. The Journal of Machine Learning Research, 3, 1157-1182.

[7] Hall, M. A. (1999). Correlation-based feature selection for machine learning (Doctoral dissertation, The University of Waikato).

[8] Kohavi, R., & John, G. H. (1997). Wrappers for feature subset selection. Artificial intelligence, 97(1), 273-324.

[9] Larranaga, P., & Lozano, J. A. (2002). Estimation of distribution algorithms: A new tool for evolutionary computation (Vol. 2). Springer Science & Business Media.

[10] Loscalzo, S., Yu, L., & Ding, C. (2009). Consensus group stable feature selection. In Proceedings of the 15th ACM SIGKDD international conference on Knowledge discovery and data mining (pp. 567-576). ACM.

[11] Lozano, J. A. (2006). Towards a new evolutionary computation: Advances on estimation of distribution algorithms (Vol. 192). Springer Science & Business Media.

[12] Liu, H., & Motoda, H. (2012). Feature selection for knowledge discovery and data mining (Vol. 454). Springer Science & Business Media.

[13] Peng, H., Long, F., & Ding, C. (2005). Feature selection based on mutual information criteria of max-dependency, max-relevance, and min-redundancy. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 27(8), 1226-1238.

[14] Vapnik, V. N., & Vapnik, V. (1998). Statistical learning theory. New York: Wiley.

[15] Vapnik, V. (2013). The nature of statistical learning theory. Springer Science & Business Media.

[16] Yang, J., & Honavar, V. (1998). Feature subset selection using a genetic algorithm. In Feature extraction, construction and selection (pp. 117-136). Springer US.

[17] Aliev, R. A. and Aliev R. R. Soft computing and Its Applications. Book. World Scientific Publishing Co. Pte. Ltd. ISBN: 981-02-4700-1.

[18] Gertosio C, Dussauchoy, A. Knowledge discovery from industrial databases. Journal of Intelligent Manufacturing, v 15, n 1, p 29-37, February 2004

[19] Xiaoliang J, Zhenming Z, Xitian T. The research and application on process planning knowledge discovery technology based on knowledge model in discrete manufacturing enterprise. 2007 International Conference on Fuzzy Systems and Knowledge Discovery, 24-27 Aug. 2007, Haikou, China

[20] Siu C. C., Shen Q., Milne R. ‘A Fuzzy Expert System for Turbomachinery Diagnosis’. Proceedings of the International Conference on Fuzzy Systems. 1997. p555-560.

[21] Gowing J., Wylie R., Henzell R., Futcher J., Reinsborough J., Coderre A., Henzell P., Vadas O. ‘Steam and Condensate Diagnostic Expert System’. Source: Preprints of the 81st Annual Meeting, Canadian Pulp and Paper Association (Technical Section). pp. A41-44. NRC Publication Number: NRC 38335, 2001.

[22] Becraft W. R., Lee. P. L., Newell R. B. ‘Integration of Neural Networks and Expert Systems for Process Fault Diagnosis’. Proceedings of the Twelfth International Conference. on Artificial Intelligence IJCAI 1991:832-837.

[23] Sgurev V., Dochev D., Agre G., Dichev C., Markov Z. ‘Diagnostic expert system for digital electronics, industrial applications of artificial intelligence’. Alty, J.L., and Mikulich, L.i (Eds), North-Holland, Amsterdan 1991, pp 220-224.

[24] Chan P. F. ‘An Expert System For Diagnosis Of Problems In Reinforced Concrete Structures’ Royal Melbourne Institute of Technology. December 1996.

[25] Lee.C.W., Choi.T., Shin.Y.C. Intelligent modelling of complex Manufacturing processes using hierarchical fuzzy basis function networks. Proceedings of the ASME Dynamic Systems and Control Division, 70: 721-728, 2002.

[26] Sung.Y.L., Fischer.G.W. Grouping parts based on geometrical shapes and manufacturing attributes using a neural network. Journal of Intelligent Manufacturing, 10, 199-209, 1999.

[27] Joo.J., Yi.G.R., Cho.H., Choi.Y.S. Dynamic planning model for determining cutting parameters using neural networks in feature-based process planning. Journal of Intelligent Manufacturing, 12, 13-29, 2001

[28] Tontini.G. Pattern identification in statistical process control using fuzzy neural networks. Proceedings of the Fifth IEEE International Conference on Fuzzy Systems, 3, 2065-2070,1996

[29] Wadi, I., Balendra.R. Using neural networks to model the blanking process. Journal of materials processing technology, 91, 52-64, 1999.

[30] Chung, Y., Kusiak.A. Grouping parts with a neural network. Journal of Manufacturing Systems, 13, 262-275, 1994.

[31] Shahbaz M., Srinivas, Harding J.A., Turner M. Product design and manufacturing process improvement using association rules Proceedings of the Institution of Mechanical Engineers, Part B (Journal of Engineering Manufacture), v 220, n B2, 243-54, Feb. 2006

[32] Montani S., Anglano C. ‘Case-Based Reasoning for Autonomous Service Failure Diagnosis and Remediation in Software Systems’. Proceeding of the European Conference on Case-Based Reasoning (ECCBR) 2006, 489-503.

[33] Olsson E., Funk P., Bengtsson M. ‘Fault Diagnosis of Industrial Robots using Acoustic Signals and Case-Based Reasoning’. Proceedings of the 7th European Conference on Case-Based Reasoning, June 2004, 686-701.

[34] Skalle P., Sveen J., Aamodt A. ‘Improved Efficiency Of Oil Well Drilling Through Case Based Reasoning’. 6th Pacific Rim International Conference on Artificial Intelligence Melbourne, Australia, August 28 -September 1, 2000, 712-722.

[35] Liao T. W., Triantaphyllou E., Chang P.C. ‘Detection of Welding Flaws with MLP Neural Network and Case Based Reasoning’. Intelligent Automation and Soft Computing, Vol. 9, No. 4, pp. 259-267, 2003, Copyright © 2003, TSI® Press, Printed in the USA. All rights reserved.

[36] Devaney M., Ram A., Qiu H., Lee J. ‘Preventing Failures By Mining Maintenance Logs With Case-Based Reasoning’. 59th Meeting of the Society for Machinery Failure Prevention Technology (MFPT-59), 2005, 369-381.

[37] Devaney M., Cheetham B. ‘Case-Based Reasoning for Gas Turbine Diagnostics’. The 18th International FLAIRS Conference, Clearwater Beach, Florida, (2005).

[38] Koyama H., Manabe K. I., Yoshihara S. A database oriented process control design algorithm for improving deep-drawing performance. Journal of Materials Processing Technology, 138, 1-3, 343-348, 2003.

[39] Manabe.K., Koyama.H., Yoshihara.S., Yagami.T. Development of a combination punch speed and blank-holder fuzzy control system for the deep-drawing process. Journal of Material Processing Technology, 125-126: 440-445, 2002.

[40] Manabe.K.I., Yoshihara.S., Yang.M., Nishimura.H. Fuzzy controlled variable blank holding force technique for circular cup deep drawing of aluminium alloy sheet. Proceedings of the NAMRC XXIII Conference, 41-46, 1995.

[41] Behrens B.A., Yun J.W. Closed-Loop Control of Deep-Drawing Processes by Means of Contact-free Measurement of the Material Flow. Production Engineering, XII, 1, 45-50, 2005.

[42] On development of an optimal control system for real-time process optimization on milling machine tools. P. Bosetti, M. Leonesio, P. Parenti. 8th CIRP Conference on Intelligent Computation in Manufacturing Engineering, 2013.

[43] A model-based adaptive controller for chatter mitigation and productivity enhancement in CNC milling machines. Giorgio Bort, C.M.a, Leonesio, M.b, Bosetti, P.a. Robotics and Computer-integrated Manufacturing 40. (2016). 34-43

[44] A comprehensive approach to parameters optimization of energy-aware CNC milling. Li, C.a, Li, L.a, Tang, Y.b, Zhu, Y.a, Li, L.c. Journal of Intelligent Manufacturing (2016). doi:10.1007/s10845-016-1233-y

[45] Sensitivity analysis of Pareto solution sets of multiobjective optimization for a batch cooling crystallization process. Hemalatha, K.b, Rani, K.Y.a Indian Control Conference (ICC), 2016.

[46] A statistical analysis applied for optimal cooling system selection and for a superior surface quality of machined magnesium alloy parts. Chirita, B., Mustea, G., Brabie, G. Proceedings of the Institution of Mechanical Engineers Part B-Journal of Engineering Manufacture 2015, 229 (3), 392.

[47] Application of optimal control problem for surface roughness improvement in milling. Skrypka, K., Bosetti, P. Volume 651-653, 2015, Pages 1217-1222. 18th International ESAFORM Conference on Material Forming, ESAFORM 2015; Graz; Austria; April 2015

[48] Optimization of Turn-milling Processes. Kara, M.E., Budak, E. 9th CIRP International Conference on Intelligent Computation in Manufacturing Engineering, CIRP ICME 2014; Capri; Italy; 23 July 2014 through 25 July 2014; Code 113642.

[49] Genetic algorithms & engineering optimization. Mitsuo Gen, Runwei Cheng. Wiley Series in Engineering Design and Automation. ISBN 0-471-31531-1.2000.